文 | 蓝字计划,作者|Hayward

一身皮衣黄仁勋,GTC 2025 上意气风发。

虽然最近英伟达的股票跌得比较狠,甚至来到了 10 年来的最低点,但这不影响老黄,对最新的 GPU 们信心满满。

时间回拨到 2 月初,DeepSeek 的发布在 AI 领域掀起巨浪。一个中国团队的产品,仅用了少量的低端 GPU(以 A100 为主) 蒸馏现有超大模型就实现了高端 GPU(以 H100 为代表) 才有的性能。

高端 GPU 并非刚需,谁还成吨地采购你老黄的 Hopper、Blackwell 核弹?过去在 AI 行业被奉为金科玉律的“Scaling Law”(规模定律),也就是“ 模型参数量、数据集、训练成本越多越好” 的观念也被严重冲击。

这几年谷歌、Meta、微软等互联网大厂成吨地采购 H100 芯片以维持规模,正是想以算力分胜负、定生死。现在根本不需要如此恐怖的规模,也能让大模型拥有媲美 OpenAI o1 的性能。

一时间,宣称 DeepSeek 能让英伟达走上末路的声音此起彼伏,特别是海外的社媒平台发酵最快、传播最凶。有 X 网友更坦言“ 英伟达的一切都将开始瓦解”,这段时间里英伟达的股票一天下跌 13%、17% 都成了常态。

不过,也有另一种声音称,从长期来看 DeepSeek 的成功反而利好英伟达。

DeepSeek 揭示了可以通过“ 蒸馏现有超大模型” 的方法训练性能出色的大模型,但只是不需要用到 H100 芯片这等性能怪兽而已,并非完全不依赖计算卡。A100 计算卡,也是英伟达家的产品。

玩家的门槛降低了,入场的玩家自然会越来越多,从市场总量来说,对算力的需求还是会上升的。英伟达又是全世界最大的卡贩子,总会卖出更多的计算卡。

再说了要蒸馏现有的超大模型,也得先有性能出色的超大模型存在才行,到底还是需要 H100 这样的计算卡集群来训练超大模型,这似乎是个“ 先有鸡还是有蛋” 的问题。

只能说两种声音都有道理,不过大家最想知道的还是老黄本人的声音。

这次 GTC 2025,我们终于等到老黄的亲自回应。

还是那个 GPU 霸主

按照惯例,我们先来回顾一下这场光门票就要价 1 万美元的“ 科技盛宴”。

简单来说,英伟达主要发布了四款芯片架构、两款 AI 电脑、一款 AI 训练底层软件和展示了具身机器人相关的进展,其他内容就不赘述了。

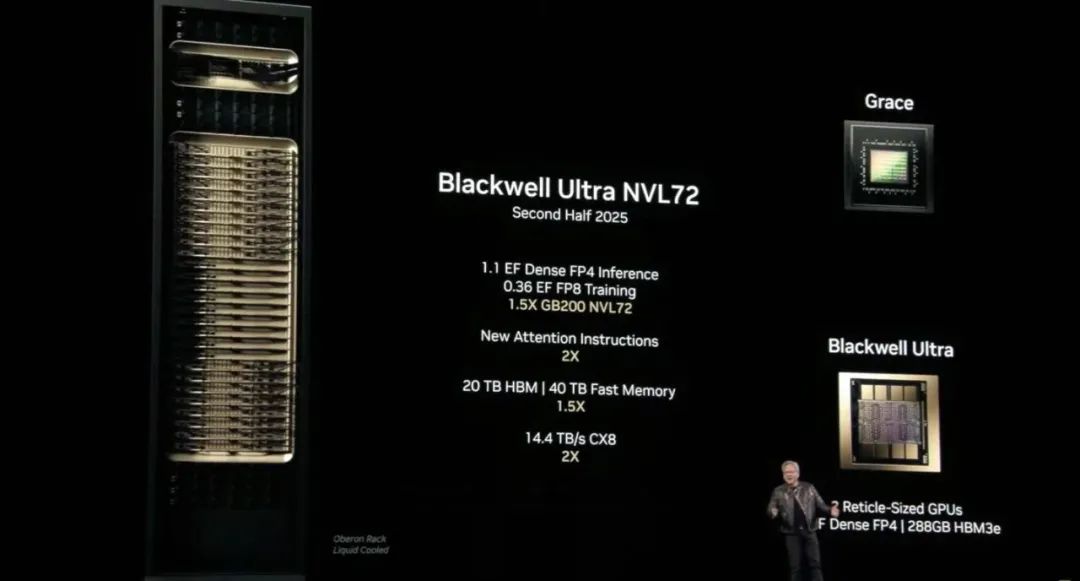

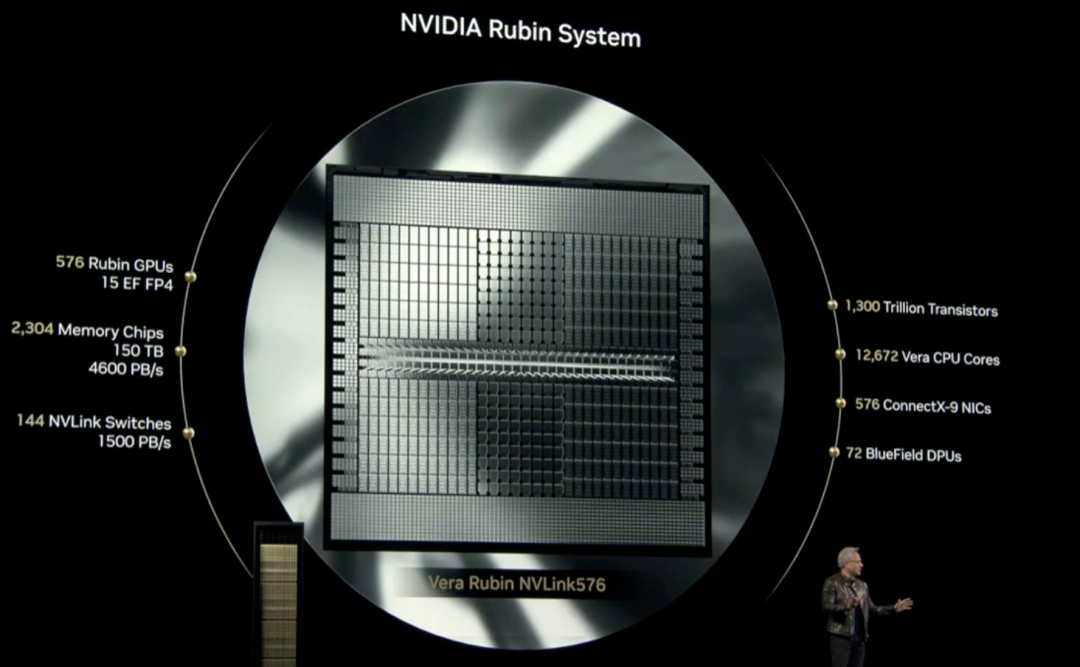

· 4 款 AI 芯片架构,分别是将在 2025 下半年发布的 Blackwell Ultra、2026 下半年发布的 Vera Rubin、2027 下半年发布的 Vera Rubin Ultra,和 2028 年的 Feynman。

全新的超级芯片产品方面,基于 Blackwell Ultra 架构的 GB300 NVL72 芯片是上代最强芯片 GB200 的继任者,推理是 GB200 NVL72 的 1.5 倍,提升幅度不算大,甚至在大会上 GB300 的直接对比对象还是 2 年前的 H100。

从市场的反应来看大部分人对 GB300 不太买账,它没有上一代 GB200 的那种“ 横空出世” 的惊喜感,要说最大的升级点,可能是 HBMe 内存提升至 288GB,就是有点“ 苹果今年发布的新机是 2TB 版本的 iPhone 16 Pro Max” 的味道了。

重头戏是英伟达未来的芯片架构规划,下代超级芯片 Rubin NVL144,比 GB300 NVL72 强了 3.3 倍;下下代的 Rubin Ultra NVL576 性能是 GB300 NVL72 的 14 倍,从画饼给出的性能来看,未来大概率还是会由英伟达掌握 GPU 算力王座。

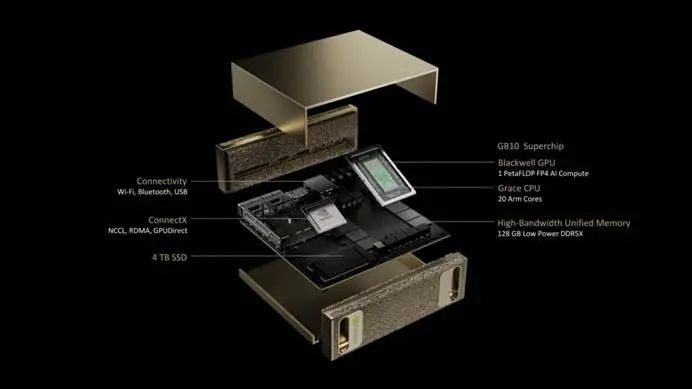

· 两款全新的 AI 电脑,分别是搭载了 GB10 Grace Blackwell 超级芯片的 DGX Spark,每秒可提供高达 1000 万亿次 AI 运算;搭载了 GB300 Grace Blackwell Ultra 的 DGX Station,可以提供每秒可提供高达 2000 万亿次 AI 运算。目前 DGX Spark 已经开始预售,要价 3000 美元。

· 开源软件 NVIDIA Dyamo,可以简单理解为一款 AI 工厂 (数据中心) 的操作系统,英伟达说在 NVIDIA Blackwell 上使用 Dynamo 优化推理,能让 DeepSeek-R1 的吞吐量提升 30 倍。

· 具身机器人的技术储备,包括机器人通用基础模型 Isaac GR00T N1、一款配备了 GR00T N1 模型的机器人:Blue,和 Google Mind、迪士尼合作的最新成果。

从发布的产品来看,英伟达还是那个 GPU 领域的霸主,甚至领导地位已经开始向 AI 拓展。它们不仅将产品技术路线图更新至一年一更,未来三年的产品堪称“ 超级大饼”,围绕 AI 相关的软件建设也在飞速推进,NVIDIA Dyamo 很可能会是未来数据中心的标配。

对于 DeepSeek 的冲击,英伟达似乎也有了解决的办法。

进入“token 时代”

终于,黄仁勋首次在公开场合,正面回应了 DeepSeek 诞生以来对公司造成的冲击。

首先他把 DeepSeek 从头到脚吹了一遍,说 DeepSeek R1 模型是“ 卓越的创新” 和“ 世界级的开源推理模型”,而且他淡定地表示,不理解为什么大家会把 DeepSeek 当成英伟达的末日。

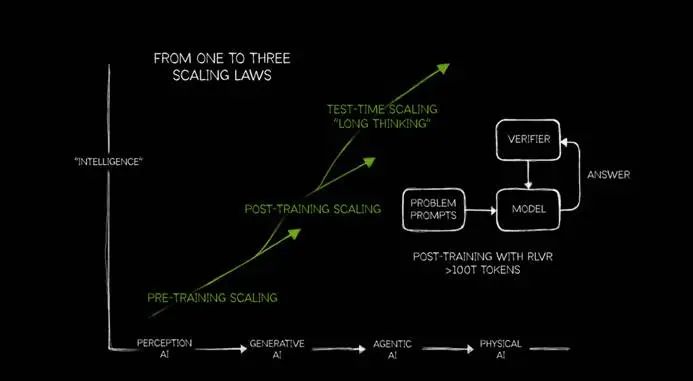

至于因 DeepSeek 而起的关于 Scaling Law 撞墙的讨论,老黄在会上给出了自己的理解。

首先,他在大会上对 Scaling Law 进行了一次迭代更新:

现在他将 Scaling Law 细化为 PRE-TRAINING SCALING、POST-TRAINING SCALING、TEST-TIME SCALING 三个部分。老黄的意思是,随着 AI 进入到不同阶段,对 Scaling 的需求是不断提高的。

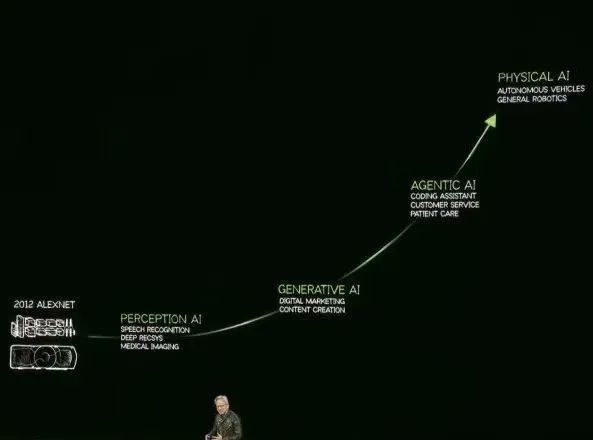

这里要提一下,老黄认为 AI 的发展分为四个阶段:感知人工智能 (Perception AI)、生成式人工智能 (Generative AI)、代理人工智能 (Agentic AI) 和未来的物理 AI(Physical AI)。而现在我们正处于代理人工智能阶段。

现阶段由于推理模型、AI 代理的爆发,实际上更加需要 Scaling,更加需要算力。

其背后的关键是 token。

以推理模型为例子,模型进行推理时,token 的消耗猛涨。用老黄的话,我们不仅需要让 token 的吞吐量提升十倍,还需要过去 10 倍的算力来提升 token 的输出速度,最终,需要的算力是之前的 100 倍。

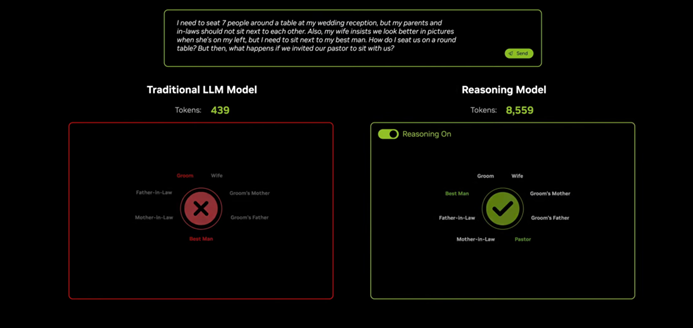

从技术上来说,这不无道理。相比传统的生成式模型,比如 ChatGPT,我们观察到它没有列举推理步骤。输入问题 → 提供答案,没中间商差价,答案所呈现的就是最终消耗的 token 数。

而拥有思维链的推理式模型,比如大家熟知的 DeepSeek R1,会有一连串的推理过程,有些时候可能推理过程的字数比答案还要多。

R1 模型能够实现推理,是因为会将输出的 token 返回上级重新思考、推理,正如比喻大师老黄所说的“ 每个 token 都会自我怀疑”,在不断的怀疑-论证中,形成了推理的过程。但这也会更多地消耗算力和 token,推理模型要比传统生成式模型多消耗的 token 不是 2 倍,而是 20 倍。

所以,我们用推理模型时,一大串的思考、推理过程要在前台展示出来,不仅因为用户可以从大模型的推理过程介入修正答案,还因为它们不是白送的,不是免费的,而是在消耗一个个 token,都是真金白银,花了钱的地方肯定得让你看到。

而且市面上的推理模型越来越多,更多的传统模型也陆续开始加入推理过程,比如谷歌的 Gemini,最终 token 的消耗会呈指数级增长。

这就是老黄坚信 Scaling Law 没有失效的底气。在会上,老黄用传统模型 Llama 3.3 70B 与 DeepSeek R1 671B 进行了对比,统一回答一个复杂问题。最终前者消耗了 400 多个 token 但结果不可用,后者的结果堪称完美,但足足消耗了 8559 个 token。

或许从蒸馏大模型的点子中节约的算力,又会消耗到推理的过程中,说不准这就是 AI 算力中的能量守恒呢。

DeepSeek 让英伟达 GPU 卖得更好

除了黄仁勋的激情论证,一个事实是,在这个高 token 消耗时代,英伟达的 GPU 的确卖得更猛了。

彭博社报道,OpenAI 预计在 「星际之门」 首期计划中,建立一个可以容纳 40 万个英伟达的 AI 芯片的数据中心综合体。全部装满的话,这会是世界最大的 AI 算力集群之一。

还有对算力推崇至极的马斯克,旗下的 xAI 已与戴尔达成 50 亿美元协议,用于在孟菲斯建设超级计算机的 AI 服务器;Meta 也宣布计划要拥有相当于 600,000 块英伟达 H100 芯片的算力。

还有国内的阿里、小米、腾讯等公司,也将部署海量算力作为主要目标。这背后的显卡供应商,毫无疑问都主要来自英伟达。推理模型铺开后大公司们对计算卡、算力的热情丝毫不减,看来至少大公司们仍相信未来是算力的时代。

在个人本地部署领域,DeepSeek R1 也没有真正地减轻个人用户的算力负担。

2 月中,全网掀起了一阵本地部署 DeepSeek R1 蒸馏模型的热潮,但从个人的经验来看,想要得到较好的模型性能,对电脑配置,也就是算力的要求一点都不低。

以 RTX 4080 16GB 显卡为例,拥有 9728 个 CUDA 核心,16GB GDDR6X 的显存带宽为 736 GB/s,在显卡中已经算高端。

但用它在本地部署 14B 的 DeepSeek R1 蒸馏模型时,大部分的推理速度只有 20-30 tokens/s,需要分析深度问题往往需要等待超过 10 分钟。

如果更进一步用它来部署 32B 的蒸馏模型,推理速度会进一步下降到 5-15 tokens/s,生成同样的回答,就需要等待超过 30 分钟。

这样的效率显然是不行的。如果想要提高推理速度,有两个办法:

选择更小参数的蒸馏模型部署,但推理的精度、答案的可靠性会明显下降;

选择更高配置的硬件,比如 RTX 5080/5090,用 5090 部署 32B 的蒸馏模型,推理速度也能达到 50-60 tokens/s,效率明显提升,但又让老黄卖卡的计划通了。

也许大多数人的算力条件,本地部署的大模型还不如直接打开腾讯元宝高效。

因此,从 DeepSeek R1 引申出来的“ 蒸馏模型节省训练算力” 已经被“ 推理模型消耗算力” 抵消,这给了英伟达全新的机遇,可以说 DeepSeek 的出现为英伟达关上了一扇门,又打开了一扇窗。

最终,我们不得不承认长远来看算力的需求还会不断增加,还是利好英伟达。虽说今年 Blackwell Ultra 挤牙膏,但后面几年的芯片架构都会有明显的算力提升。当各大厂的算力吃紧时,老黄的核弹们,又有大展拳脚的机会了。

贩卖 token 焦虑?

纵观 GTC 2025,只要是涉及 AI、GPU、算力的部分,老黄都离不开 token,甚至有好事的媒体专门统计了他在会上提到“token” 的次数,还怪幽默的。

在新 Scaling Law 时代,token 仿佛成了英伟达的救命稻草。虽然从逻辑上看老黄的观点说得通,但如此频繁地重复一种逻辑,就像我们在文章中连续写 100 次“token”,多少会有人觉得,英伟达有点歇斯底里。

自农历新年以来,英伟达的市值已经跌去了将近 30%,这次发布会的黄仁勋不再像一个技术大拿,不像是那个“ 全世界最聪明的科学家”、“ 全球最牛公司的 CEO”,而像一个絮絮叨叨的金牌销售,通过贩卖 token 焦虑的方式,让大家坚信英伟达仍掌握着未来。

不过投资者的信心不来自推销和布道,而来自产品。事实就是今年下半年面世的 GB300 确实没有太多亮点,画的大饼又比较遥远。反映到股价上,发布会结束后英伟达的股价依然下跌了 3.4%。

其实更令我哭笑不得的是价值 3000 美元的 DGX Spark,根据官网披露的信息这款产品的 128GB 内存,带宽只有 273GB/s。

尽管老黄将它定义为“ 可用于本地部署” 的 AI 电脑,但这性能真不敢恭维。不说满血版 671B 的 DeepSeek R1,跑大部分 32B 的模型可能也只能实现 2-5 tokens/s 的输出效率。用它来跑传统的模型应该还不赖,但推理模型估计是很困难了。

或许它存在的意义,停留在“ 让大家买更强的 DGX Station” 上罢了。只是如果你一直在贩卖 token 焦虑,最好能拿出更多能解决 token 焦虑的产品来。

英伟达现在缺乏的不是技术和产品,在 GPU 领域一骑绝尘,第二名都看不到车尾灯;真正缺乏的,是对消费者的诚意。

参考资料:

APPSO《刚刚,黄仁勋甩出三代核弹 AI 芯片!个人超算每秒运算 1000 万亿次,DeepSeek 成最大赢家》

第一财经 《凌晨,黄仁勋重大宣布!》

图片来源:GTC March 2025 Keynote with NVIDIA CEO Jensen Huang

更多精彩内容,关注钛媒体微信号 (ID:taimeiti),或者下载钛媒体 App