来源:

界面新闻

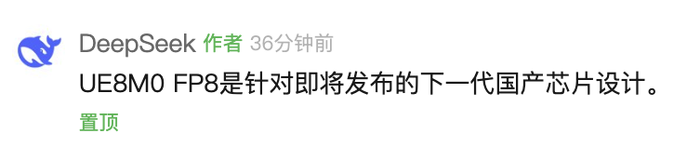

8 月 21 日,DeepSeek 在其官宣发布 DeepSeek-V3.1 的文章中提到,DeepSeek-V3.1 使用了 UE8M0 FP8 Scale 的参数精度。另外,V3.1 对分词器及 chat template 进行了较大调整,与 DeepSeek-V3 存在明显差异。DeepSeek 官微在置顶留言里表示,UE8M0 FP8 是针对即将发布的下一代国产芯片设计。

相关报道

DeepSeek 发布新模型 V3.1 价格涨了但 Agent 能力提升了

8 月 21 日,业界千呼万唤的 R2 模型没来,但 DeepSeek 官方正式发布了新模型 V3.1。从命名来看这或许不是一次大的版本更新,更像是前一代 DeepSeek-V3 模型的小版本迭代。

在 X 上,DeepSeek 将 V3.1 称为 「我们迈向智能体时代的第一步」(our first step toward the agent era)。本次升级主要有三大亮点,其中包括更强的 Agent 能力、混合思考模式和更高的思考效率。

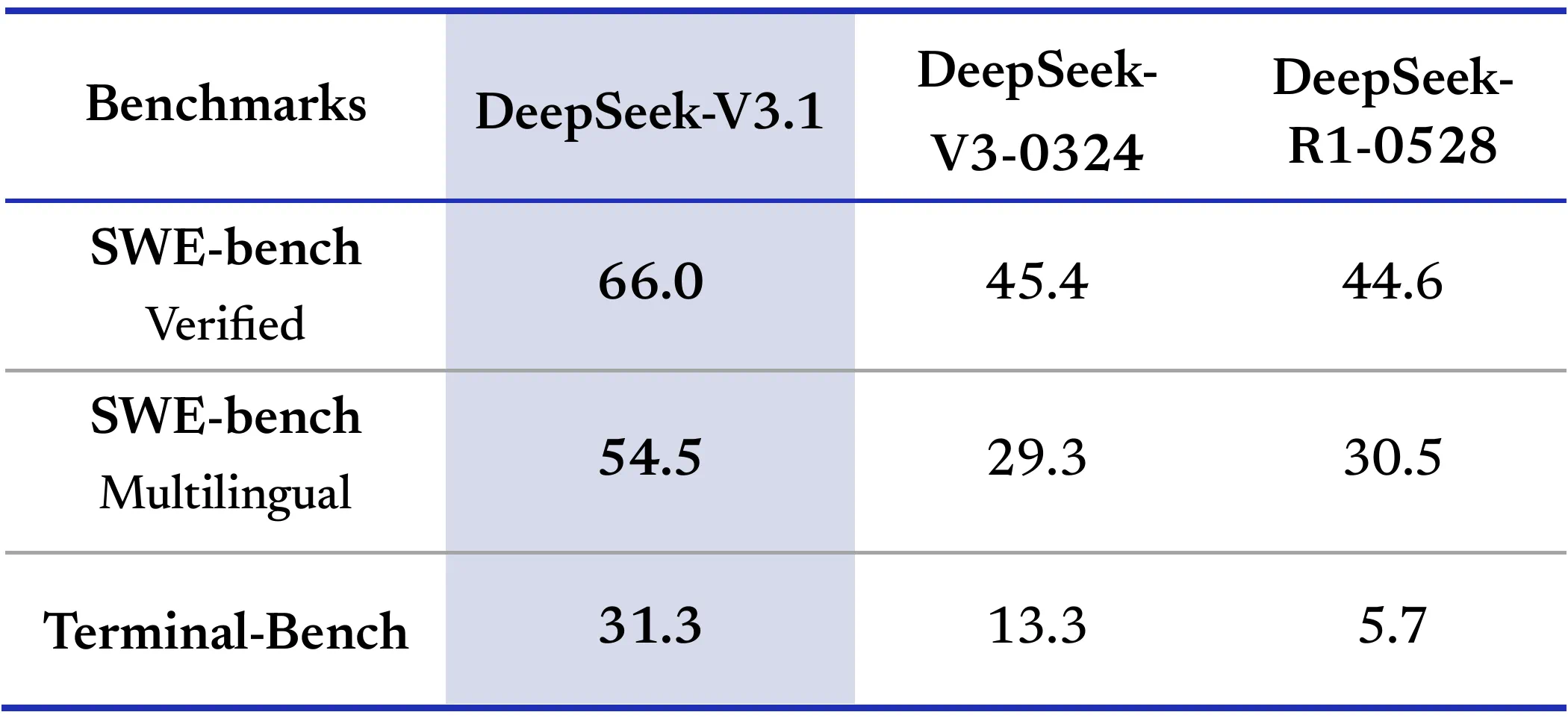

官方表示,通过后训练优化,新模型在工具使用与智能体任务中的表现有较大提升。在编程智能体、搜索智能体测评中, V3.1 相比之前的 DeepSeek 系列模型都有明显提高。

DeepSeek-V3.1 是混合推理架构,一个模型同时支持思考模式和非思考模式。目前用户可在官方 App 与网页端体验新模型,通过 「深度思考」 按钮,实现思考模式与非思考模式的自由切换。DeepSeek API 也已同步升级,deepseek-chat 对应非思考模式,deepseek-reasoner 对应思考模式,且上下文均已扩展为 128K。

「混合推理非常棒。拥有一个能够在深度思考和快速响应之间切换的模型,感觉就像是实用人工智能的未来。」X 上有网友表示,「在深度推理和快速反应之间切换真是天才之举。」 根据查询调整深度,可以避免在简单任务上过度耗时,同时在需要时进行全面分析。

与之前的版本相比,V3.1 也有更高的思考效率。官方表示,DeepSeek-V3.1-Think 在保持与 DeepSeek-R1-0528 相当的答案质量的同时,响应速度更快。

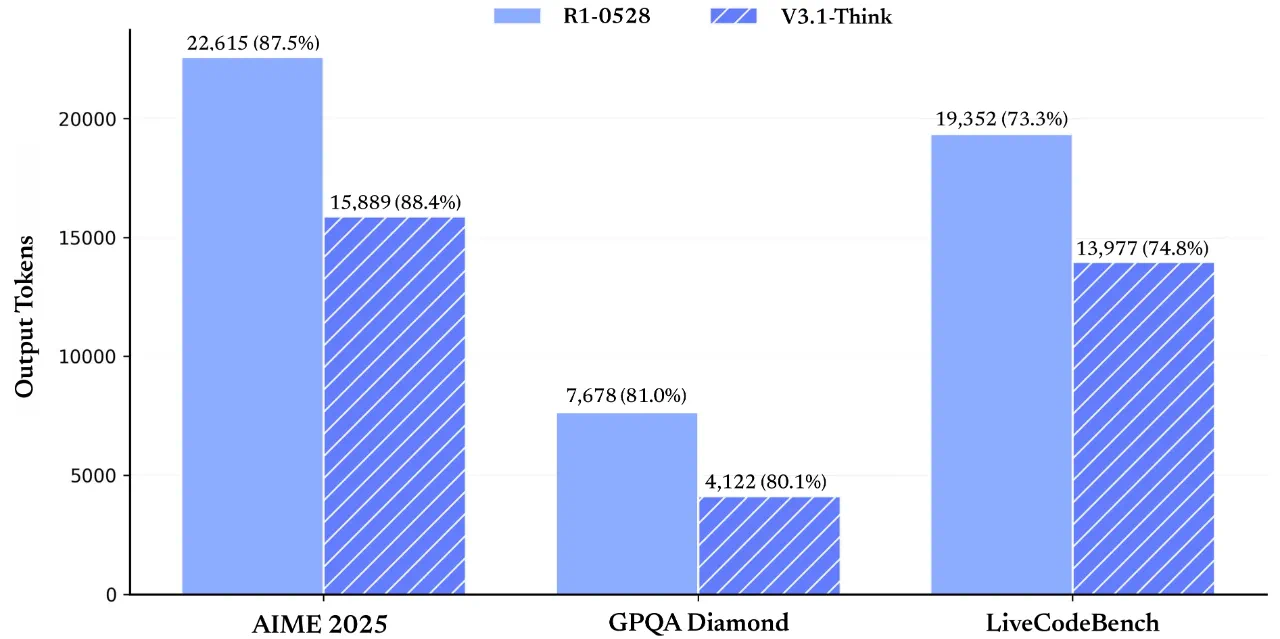

官方测试结果显示,经过思维链压缩训练后,V3.1-Think 在输出 token 数减少 20%-50% 的情况下,各项任务的平均表现与 R1-0528 持平。

同时,V3.1 在非思考模式下的输出长度也得到了有效控制,相比于 DeepSeek-V3-0324 ,能够在输出长度明显减少的情况下保持相同的模型性能。

同步地,DeepSeek 进行了价格调整,模型的 API 接口调用价格有所上涨。自 9 月 6 日凌晨起,取消夜间时段优惠,输入价格上,缓存命中时为 0.5 元/百万 tokens,缓存未命中的价格则为 4 元/百万 tokens(此前 V3 为 2 元/百万 tokens);输出价格为 12 元/百万 tokens(此前 V3 为 8 元/百万 tokens)。

官方提到,V3.1 的基础模型在 V3 的基础上重新做了外扩训练,一共增加训练了 840B tokens。基础模型与后训练模型均已在 Huggingface 与魔搭开源。

值得一提的是,DeepSeek 此次还宣布增加了对海外模型 Anthropic API 格式的支持,官方提到这是 「为了满足大家对 Anthropic API 生态的使用需求」,用户可以将 DeepSeek-V3.1 的能力接入 Claude Code 框架。

(界面新闻)

文章转载自东方财富