来源:

上海证券报

恰逢 DeepSeek-R1 模型发布一周年,DeepSeek 新模型 「MODEL1」 现身开源社区。

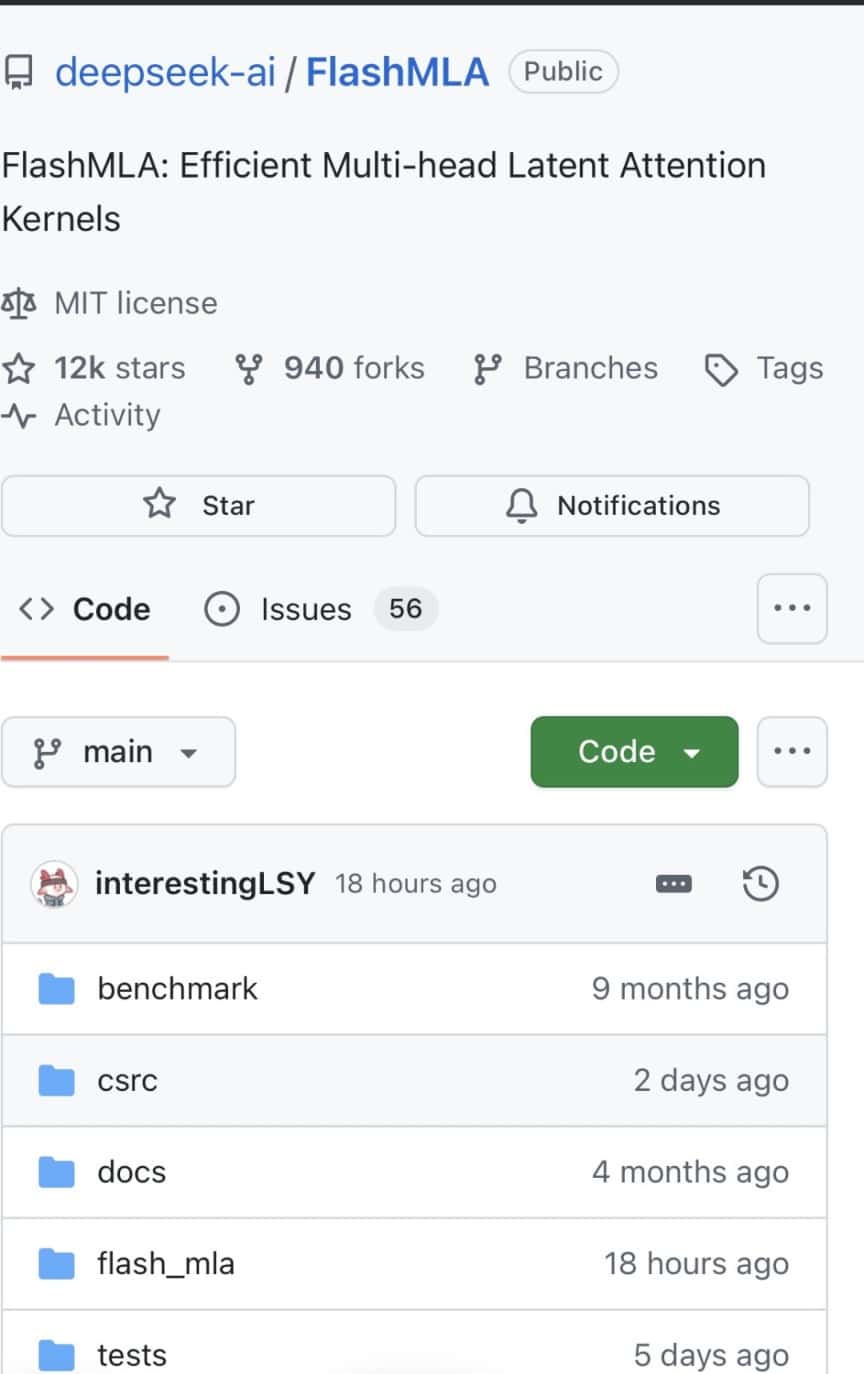

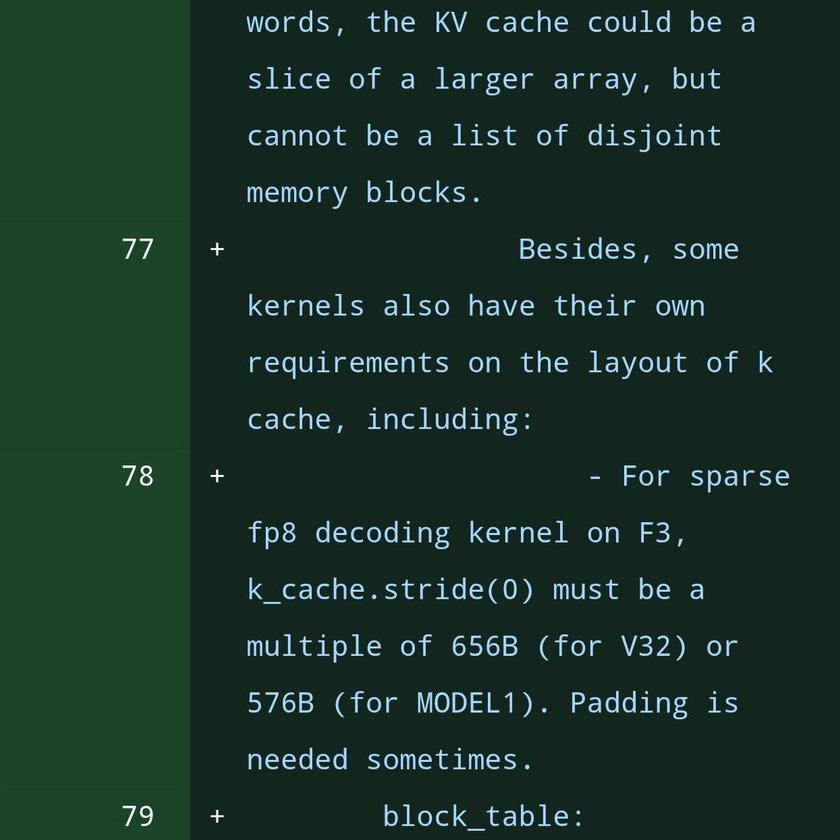

近日,DeepSeek 官方在 GitHub 更新了一系列 FlashMLA 代码,涉及的 114 个文件中,有数十处提到了此前未公开的 「MODEL1」 大模型标识符。

2025 年 2 月,DeepSeek 启动 「开源周」,计划以每日解锁的形式逐步公开 5 个代码库,Flash MLA 为首个开源项目。公开资料显示,Flash MLA 通过优化 Hopper GPU 的内存访问和计算流程,显著提高可变长度序列的处理效率。其核心设计包括动态内存分配机制和并行解码策略,可减少冗余计算并提升吞吐量,尤其适用于大语言模型的推理任务。

在某些文件中,「MODEL 1」 与已知的现有模型 「V32」(即 DeepSeek-V3.2) 并列提及。行业分析认为,「MODEL1」 或许代表一个不同于现有架构的新模型,可能正是 DeepSeek 还未对外发布的下一代模型 (R2 或者 V4)。

此前有市场消息称,DeepSeek 计划在 2 月春节前后发布新一代 AI 模型 DeepSeek V4,但发布时间可能会视实际情况而变化。V4 模型是 DeepSeek 2024 年 12 月发布的 V3 模型的迭代版,具备强大的编程能力。DeepSeek 内部的初步测试显示,V4 在编程能力上超过了目前市场上的其他顶级模型,如 Anthropic 的 Claude 和 OpenAI 的 GPT 系列。

2026 年 1 月以来,DeepSeek 动作不断,已陆续发布了两篇技术论文,分别介绍了名为 「优化残差连接 (mHC)」 的新训练方法,以及一种受生物学启发的 「AI 记忆模块 (Engram)」。

1 月 12 日,DeepSeek 在 github 上发表新论文,文章由 DeepSeek 与北京大学合作完成,作者中有梁文锋署名。文章指出,Transformer 架构缺乏原生的知识查找机制,迫使它们通过计算低效地模拟检索。为此,DeepSeek 提出了条件记忆 (conditional memory),并给出了实现方案 Engram 模块。DeepSeek 称,该模块不仅有助于知识检索,同时在一般推理和代码/数学领域方面取得了更大的进步。

在业内看来,梁文锋旗下私募幻方量化较高的收益率,为 DeepSeek 的研发提供了更多支持。公开资料显示,幻方量化 2025 年的收益均值达 56.55%,在中国管理规模超百亿的量化私募业绩榜中位列第二,仅次于以 73.51% 收益均值登顶的灵均投资。目前,幻方量化管理规模已超 700 亿元。

(上海证券报)

文章转载自东方财富