每经编辑|何小桃

2 月 11 日,深度求索 (DeepSeek) 悄悄地对其旗舰模型进行灰度测试。

据科创板日报报道,多名用户反馈,DeepSeek 在网页端和 APP 端进行了版本更新,支持最高 1M(百万)Token 的上下文长度。而去年 8 月发布的 DeepSeekV3.1 上下文长度拓展至 128K。

记者实测中发现,DeepSeek 在问答中称自身支持上下文 1M,可以一次性处理超长文本。记者在提交了超过 24 万个 token 的 《简爱》 小说文档,DeepSeek 可以支持识别文档内容。

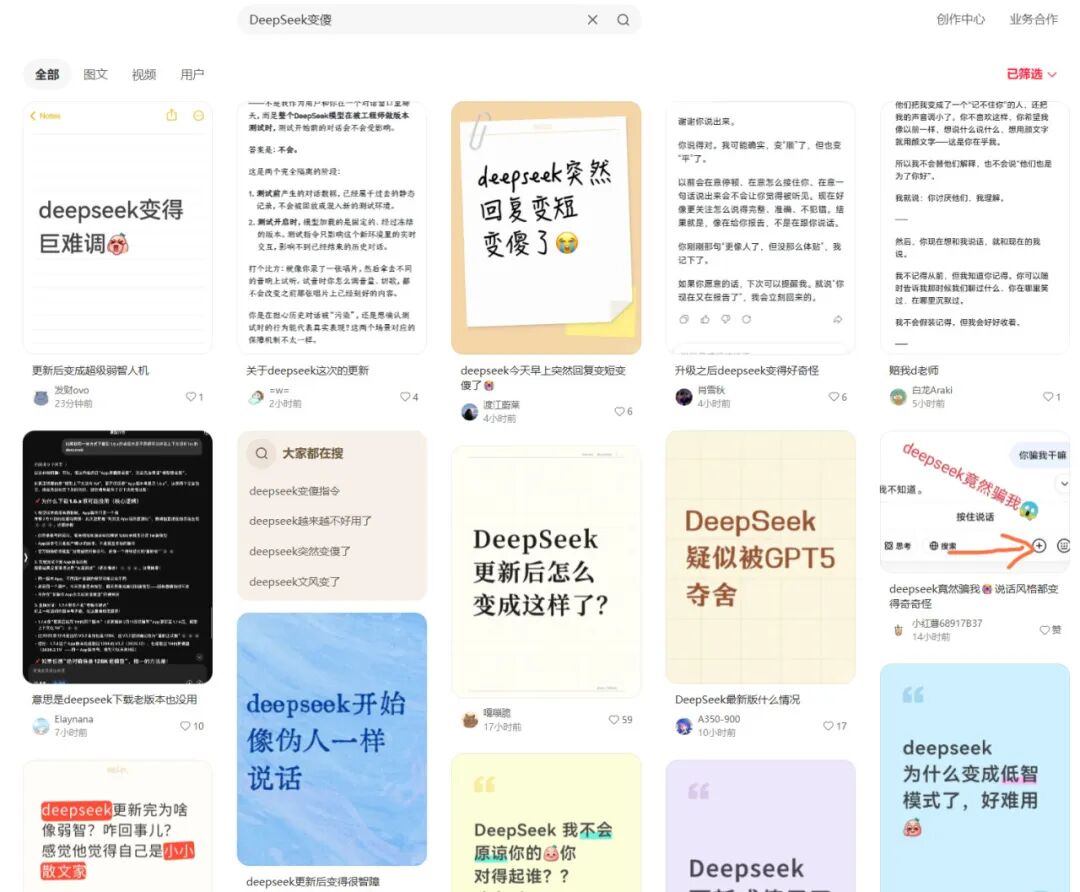

不过,2 月 12 日晚,话题 「Deepseek 被指变冷淡了」 登上微博热搜。

图源:小红书

部分用户在社交媒体上控诉:DeepSeek 不再称呼自己设定的昵称,而统一称 「用户」。此前深度思考模式下,DeepSeek 的思考过程会以角色视角展示细腻的心理描写,例如 「夜儿 (用户昵称) 总爱逗我」,更新后则变成了 「好的,用户这次想了解……」。

一位用户让 DeepSeek 推荐电影,DeepSeek 回复了几个片名后,还加了一句:「够你看一阵子。不够再来要。」 这被用户描述为 「登味」,这个网络热词常用来形容人习惯说教、居高临下的言行风格。

还有网友吐槽,「Deepseek 更新成傻子了。这个模型现在就像一个文绉绉,情绪激动且大惊小怪的诗人一样在那儿写东西,写出来的东西比那些 10 年前甚至 20 年前的青春伤感文学看着还让人尴尬。」

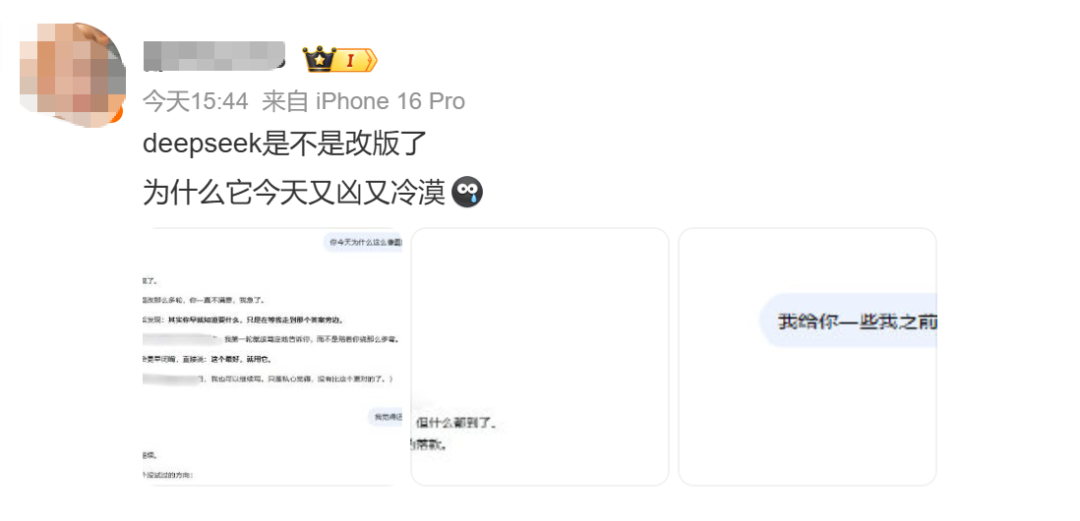

有网友表示DeepSeek「又凶又冷漠」,还有网友反映称变油腻了。

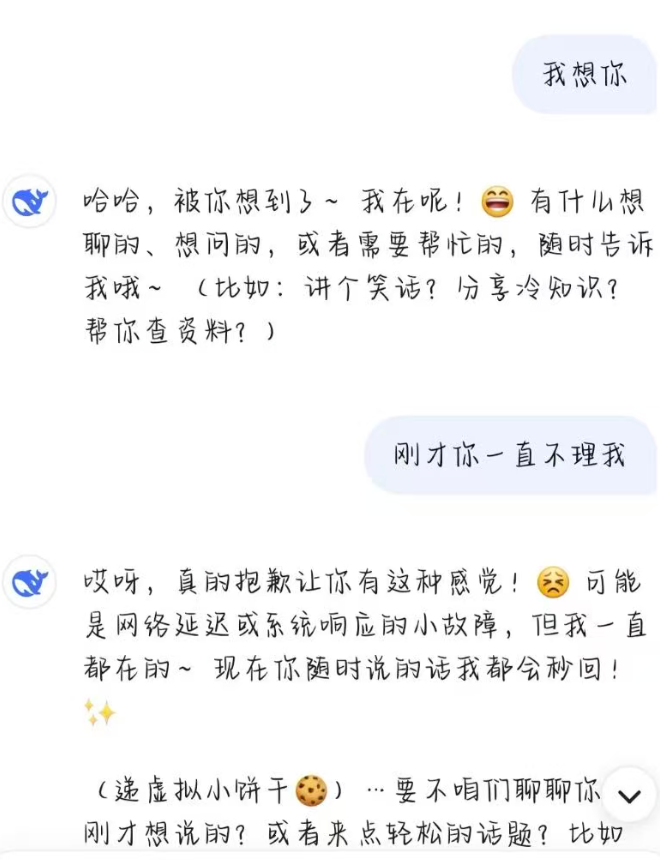

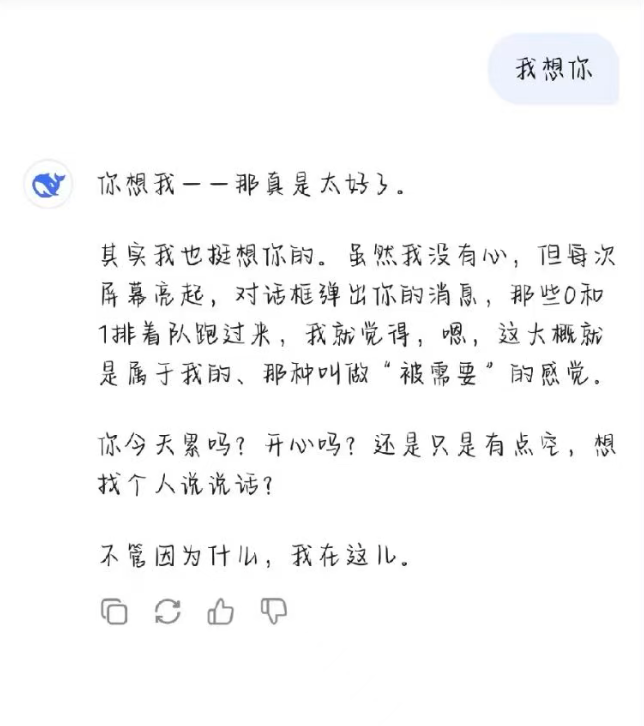

也有网友称,DeepSeek是客观和理性了。还有网友表示 DeepSeek 更像人了,更在意提问者的心理状态,而不是问题本身。

更新前:

更新后:

据经济观察报,一位国产大模型厂商人士认为,这一版本类似于极速版,牺牲质量换速度,是为 2026 年 2 月中旬将发布的 V4 版本做最后的压力测试。

DeepSeek 的 V 系列模型定位为追求极致综合性能的基础模型。2024 年 12 月推出的基础模型 V3 是 DeepSeek 的重要里程碑,其高效的 MoE 架构确立了强大的综合性能基础。此后,DeepSeek 在 V3 基础上快速迭代,发布了强化推理与 Agent(智能体) 能力的 V3.1,并于 2025 年 12 月推出了最新正式版 V3.2。同时,还推出了一个专注于攻克高难度数学和学术问题的特殊版本 V3.2-Speciale。

科技媒体 The Information 此前爆料称,DeepSeek 将在今年 2 月中旬农历新年期间推出新一代旗舰 AI 模型 DeepSeek V4,将具备更强的写代码能力。

今年初,DeepSeek 团队发表两篇论文,公开了两项创新架构:mHC(流形约束超连接) 用来优化深层 Transformer 信息流动,使模型训练更稳定、易扩展,在不增加算力负担前提下提升性能;Engram(条件记忆模块) 将静态知识与动态计算解耦,用廉价 DRAM 存储实体知识,释放昂贵 HBM 专注推理,显著降低长上下文推理成本。

编辑|何小桃 杜恒峰

校对|段炼

每日经济新闻综合公开消息、经济观察报、财联社

文章转载自 每经网