亚马逊旗下云计算部门 AWS 的负责人表示,公司正在全球范围内加速扩建服务器场,并寻求获得更多英伟达最新的人工智能芯片。

周五 (5 月 30 日),AWS 首席执行官 Matt Garman 告诉媒体,今年早些时候,AWS 在墨西哥开设了一个数据中心集群,此外还在智利、新西兰、沙特阿拉伯等地建设新设施。

亚马逊此前表示,其人工智能业务有望在全年带来数十亿美元的营收。Garman 补充道,这一数字 「来自 AWS」,代表的是客户对其按需 AI 服务的使用量。

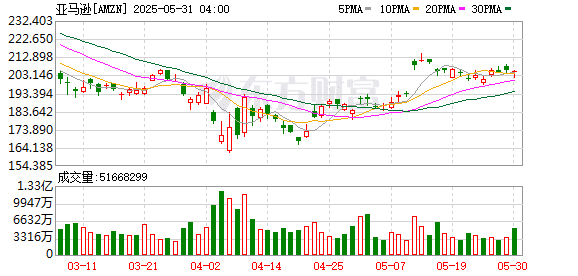

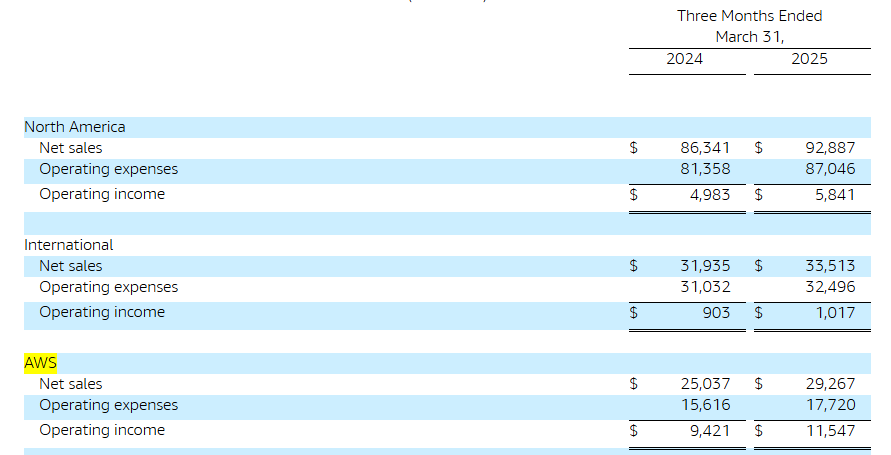

据了解,AWS 是全球最大的计算能力与数据存储租赁服务提供商,领先微软的 Azure 和谷歌云。本月早些时候,亚马逊公布的财报显示,AWS 云业务第一季度营收录得 292.67 亿美元,同比增长 17%。

但这一增速明显低于微软和谷歌的竞品。微软此前发布的财报显示,Azure 云业务的收入增长了 21%;谷歌云的收入则增长了 28%。

和微软、谷歌一样,亚马逊也在加快扩充 AI 运算能力。Garman 称 AWS 正与英伟达合作,扩大其对这家顶级芯片制造商 GB200 芯片的储备,目前这些芯片已供 AWS 客户测试使用。

先前有报道称,英伟达的供应链合作伙伴——包括富士康、英业达、戴尔、纬创等,已攻克 GB200 AI 服务器机架的一系列技术难题,其出货量正在迅速攀升。

GB200 人工智能机架包含 36 个 Grace 中央处理器和 72 个 Blackwell 图形处理器,通过英伟达的 NVLink 通信系统进行连接。

Garman 说道:「需求非常强劲。」Garman 长期担任 AWS 的工程主管,后来担任销售主管,一年前他接替 Adam Selipsky 出任该部门的 CEO。

Garman 表示,他欢迎 OpenAI 的模型能够部署在 AWS 上,尽管目前这家 AI 初创公司的模型运行在微软的服务器上。

不过,OpenAI 年内早些时候获得了探索其他合作的许可,前提是微软不愿意自己承接这项业务。

Garman 称,「我们鼓励所有合作伙伴在其他平台也能使用。我非常希望其他公司也采取类似的态度。」

他还表示,如果亚马逊合作伙伴 Anthropic 所开发的 AI 模型 Claude 登陆到微软的云平台上,「那也没关系」。

「Claude 能将服务部署到别处,这是好事,不过我们看到其绝大多数使用仍发生在 AWS 上。」Garman 说。

(财联社)

文章转载自 东方财富