来源:

证券时报

豆包大模型重磅升级,并推出创新性的 「区间定价」 模式,打响了一场平衡成本与性能的 「价值战」。

6 月 11 日,字节跳动旗下火山引擎举办 Force 原动力大会。会上,豆包大模型家族全面升级,火山引擎发布了豆包大模型 1.6、豆包视频生成模型 Seedance 1.0 Pro、实时语音与播客等新模型,并升级了 Agent(智能体) 开发平台等 AI 云原生服务。除了主论坛外,本次大会还将举办多场从技术革新到行业场景落地的分论坛,涉及芯片、汽车、智能终端、软件应用等领域的众多企业合作伙伴。

综合来看,本次大会的核心关键词有三个,分别是性能升级、成本下降、应用普惠。性能升级上,权威测评成绩显示,豆包 1.6—thinking 的表现已跻身全球前列;成本下降上,豆包 1.6 首创按 「输入长度」 区间定价,使综合使用成本降至豆包 1.5 深度思考模型的三分之一;AI 普惠上,在性能与成本的双重加持下,有望加速智能体的大规模应用落地。

豆包大模型 1.6 发布,性能跻身全球前列

会上,最受关注的当属豆包大模型 1.6 系列的重磅发布。

其中,豆包 1.6 是全功能综合模型,支持 256K 长上下文,能够自适应思考 (即自动判断是否开启深度推理);豆包 1.6—thinking 则强化深度推理,编码、数学、逻辑能力显著提升,支持复杂智能体构建;豆包 1.6—flash 则是极速版本,具有低延迟特点,适用于智能客服、语音助手等实时交互场景。

据会上披露的多项权威测评成绩,在复杂推理、竞赛级数学、多轮对话和指令遵循等测试集上,豆包 1.6—thinking 的表现已跻身全球前列。

此外,豆包 1.6 还在多模态能力上取得了新突破,支持实时视频通话分析、商品图片同款识别等。据火山引擎总裁谭待介绍,豆包 1.6 系列模型支持多模态理解和图形界面操作,能够理解和处理真实世界问题。此前,豆包 1.5 的多模态能力在 60 个公开评测基准中取得 38 项最佳成绩,已广泛应用在电商识图、自动驾驶数据标注、门店巡检等场景。图形界面操作能力则让豆包 1.6 进一步具备 「行动力」。

除了豆包大模型 1.6 系列,视频生成模型 Seedance 1.0 pro 也在本次大会上亮相。在国际知名评测榜单 Artificial Analysis 上,Seedance 在文生视频、图生视频两项任务上均排名首位,超越了谷歌的 Veo3、快手的可灵 2.0 等优秀模型。

使用成本下降至 1/3,首推 「区间定价」

一直以来,豆包大模型都在积极推动降低成本,屡屡刷新行业价格底线。本次大会,豆包大模型 1.6 的价格体系也成了关注焦点。

会上,谭待表示,通过技术和商业的双重创新,豆包 1.6 首创按 「输入长度」 区间定价,深度思考、多模态能力与基础语言模型统一价格。这一定价体系打破了行业的定价规则,让企业以更低成本获取更强 AI 能力。

具体来看,根据以往的模型定价机制,大模型按 tokens(文本基本处理单元) 收费,输入输出的 tokens 数量直接决定成本。例如输入 1000 字的中文文本约生成 1500 个 tokens,而输出 1000 字则需约 1500 个 tokens,上下文长度是成本的核心变量。

而根据豆包大模型 1.6 的定价策略,其主要有两大核心特点:

一是统一价格,消除功能溢价。这意味着,无论是否开启深度思考或多模态功能,豆包大模型 1.6 的 token 价格完全一致,打破行业惯性,让企业无需为非必要功能支付额外成本。

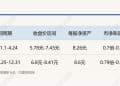

二是分区调度,可精准匹配需求。豆包大模型 1.6 将定价区间按照输入长度分为 0—32K 区间、32K—128K 区间和 128K—256K,价格随着输入长度的增加而增加。其中,在企业使用量最大的 0—32K 输入区间,豆包 1.6 的输入价格为 0.8 元/百万 tokens、输出 8 元/百万 tokens,综合成本只有豆包 1.5 深度思考模型或 DeepSeek R1 的三分之一。

豆包 1.6 与豆包 1.5thinking 综合使用成本对比

此外,Seedance 1.0 pro 模型每千 tokens 仅 0.015 元,每生成一条 5 秒的 1080P 视频只需 3.67 元,为行业最低。

谭待表示,之所以按 「输入长度」 区间定价,是因为火山引擎观察到,模型成本存在 「成本递增效应」,即随着上下文长度增加,模型处理每个 token 的计算复杂度呈指数级上升。例如有些模型在处理超过 128K tokens 时收费翻倍,因其注意力机制需与前文所有 tokens 进行关联计算。「当前,超过 80% 的企业调用请求集中在 32K tokens 以内。若能针对这一主流区间优化调度,可显著降低整体成本。」 谭待说。

因此,豆包大模型 1.6 通过区间定价模式,能够在性能与成本之间取得平衡,从而精准匹配企业需求分布。

加速 Agent 的大规模落地

「豆包 1.6 的定价策略不仅是一次简单的降价,更是 AI 普惠的战略升级。」 字节跳动火山引擎表示。

业内人士普遍认为,2022 年年底,Chat GPT 的横空出世引爆了 AI 大模型,经过两年多技术迭代,如今 AI 智能体已成为行业焦点和落地方向。2025 年是智能体爆发元年,智能体在金融、汽车、教育、港口、矿山、运营、客服等多个领域密集涌现。

然而,在 AI 智能体快速发展的当下,规模化落地面临多重挑战。根据行业观察,企业级 Agent 的实际应用成本压力尤为突出,单个 Agent 每日 token 消耗成本可达 20 美元。IDC 数据显示,2024 年中国 AI 智能体市场规模仅 50 亿元,远低于预期,反映出企业对高成本的观望心态。

因此,豆包大模型 1.6 的定价策略锚定成本高这一痛点,以上下文长度为核心的分区间定价模式,使企业使用成本降至行业平均的 1/3 左右,有望加速 Agent 的大规模落地应用。

事实上,豆包大模型近年来在市场上不断 「攻城略地」,使用量也呈现出爆发性增长的态势,据火山引擎披露,豆包大模型日均 tokens 调用量从去年 12 月的 4 万亿飙升至 2025 年 5 月的 16.4 万亿。年增长率超 300%。

同时,火山引擎也凭借快速增长的势头,「搅动」 着云市场原有的市场格局。IDC 发布的 《中国公有云大模型服务市场格局分析,2025 年一季度》 报告显示,2024 年中国公有云大模型调用总量达到 114.2 万亿 tokens,其中火山引擎占据 46.4% 的市场份额,位列第一,调用量几乎等于阿里云与百度云之和。

业内人士分析称,正如豆包 1.0 以极致性价比开启了大模型的规模调用时代,豆包 1.6 在性能与成本上的优化,或将加速 Agent 的大规模落地,降低企业 AI 应用门槛,进而巩固火山引擎在 AI 云原生基础设施领域的领导地位。

(证券时报)

文章转载自东方财富