来源:

澎湃新闻

DeepSeek 开源新模型:用视觉模式实现上下文压缩。

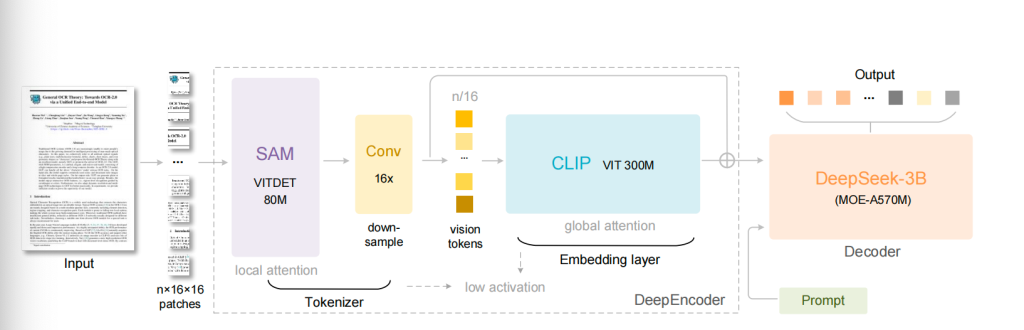

10 月 20 日,DeepSeek 宣布开源最新大模型 DeepSeek-OCR。所谓的 OCR,据 DeepSeek 在论文中解释称,是通过光学 2D 映射压缩长上下文可行性的初步研究。DeepSeek-OCR 由两部分组成:DeepEncoder 和作为解码器的 DeepSeek3B-MoE-A570M。DeepEncoder 作为核心引擎,设计为在高分辨率输入下保持低激活,同时实现高压缩比,以确保视觉 tokens 数量优化且可管理。

通俗而言,这是一种视觉-文本压缩范式,通过用少量的视觉 token 来表示原本需要大量文本 token 的内容,以此降低大模型的计算开销。

据公布的论文名单显示,该项目由 DeepSeek 三位研究员 Haoran Wei、Yaofeng Sun、Yukun Li 共同完成,但这三位核心作者都颇为低调,其中一作作者 Haoran Wei 曾在阶跃星辰工作过,曾主导开发旨在实现 「第二代 OCR」 的 GOT-OCR2.0 系统。

DeepSeek-OCR 的架构分为两部分。一是 DeepEncoder,一个专为高压缩、高分辨率文档处理设计的视觉编码器;二是 DeepSeek3B-MoE,一个轻量级混合专家语言解码器。这款刚开源不久的新模型,发布后就得到海外科技媒体广泛赞美,有网友盛赞:「这是 AI 的 JPEG 时刻。」

前特斯拉AI 总监、OpenAI 创始成员安德烈·卡帕西 (Andrej Karpathy) 在社交媒体高度评价 DeepSeek 的新模型,他表示,自己相当喜欢新的 DeepSeek-OCR 论文,「它是一个很好的 OCR 模型 (可能比 dots 稍微差一点),是的,数据收集等等,但无论如何都不重要。对我来说更有趣的部分 (尤其是作为一个以计算机视觉为核心,暂时伪装成自然语言的人) 是像素是否比文本更适合作为 LLM 的输入。作为输入,文本标记是否浪费且糟糕。」

根据他的设想,或许所有 LLM 的输入都只应该是图像。即便是纯文本内容,也应该先渲染成图片再输入给模型,其中理由包括:信息压缩效率更高、像素更通用、支持双向注意力、可淘汰存在安全隐患的分词器 (Tokenizer)。

特斯拉创始人马斯克 (Elon Musk) 也现身评论区,并表示:「从长远来看,AI 模型超过 99% 的输入和输出都将是光子,没有其他任何东西可以规模化。」

知名科技媒体 《麻省理工科技评论》 解释称,DeepEncoder 是整个系统的关键所在。它的设计目标在于,在处理高分辨率输入图像的同时,保持较低的激活内存,并实现极高的压缩比。为达到这一目的,DeepEncoder 融合两种成熟的视觉模型架构:SAM(Segment Anything Model) 和 CLIP(Contrastive Language–Image Pre-training)。前者以窗口注意力机制 (window attention) 见长,擅长处理局部细节,构成编码器的前半部分;后者则依赖密集的全局注意力机制 (global attention),能够捕获整体知识信息。

《麻省理工科技评论》 表示,除了文本识别性能,DeepSeek-OCR 还具备较强的 「深度解析」 能力。这得益于其训练数据中包含了图表、化学分子式、几何图形等多样化的视觉内容。因此,模型不仅能识别标准文本,还能对文档中嵌入的复杂元素进行结构化解析。例如,它可以将报告中的图表转换为表格数据,将化学文献中的分子式输出为 SMILES 格式,或解析几何图形中的线段关系。这种超越传统文本识别的能力,拓展了其在金融、科研、教育等专业领域的应用空间。

DeepSeek 介绍,实验表明,当文本 tokens 数量在视觉 tokens 的 10 倍以内 (即压缩比<10×) 时,模型可达到 97% 的 OCR 精度。即使在 20×压缩比下,OCR 精度仍保持在约 60%。这为历史长上下文压缩和 LLM 中的记忆遗忘机制等研究领域展示可观前景。

DeepSeek-OCR 还初步验证上下文光学压缩的可行性,证明模型可以从少量视觉 tokens 中有效解码超过 10 倍数量的文本 tokens。DeepSeek-OCR 也是一个高度实用的模型,可大规模生产预训练数据,「未来,我们将进行数字-光学文本交错预训练、大海捞针测试等进一步评估,继续推动这一有前景的研究方向。」

据海外科技媒体分析,研究团队表示,在基准测试中,DeepSeek-OCR 优于多个主流模型,且使用的视觉 tokens 数量少得多。此外,单张 A100-40G GPU 每天可生成超过 20 万页的训练数据,可为大型语言模型和视觉-语言模型的开发提供支持。

前网易副总裁、杭州研究院执行院长汪源发文表示,DeepSeek-OCR 模型是一个专门能 「读懂」 图片里文字的 AI 模型。但厉害的地方不是简单 「识字」,是采用了一种非常新颖的思路:把文字当成图片来处理和压缩。

汪源认为,可以把它想象成一个超级高效的 「视觉压缩器」,传统的 AI 模型是直接 「读」 文本,但 DeepSeek-OCR 是先 「看」 文本的图像,然后把一页文档的图片信息高度压缩成很少的视觉 tokens。DeepSeek-OCR 的能力强在能把一篇 1000 字的文章,压缩成 100 个视觉 tokens。在十倍的压缩下,识别准确率可以达到 96.5%。

(澎湃新闻)

文章转载自东方财富