作者:

喻琰

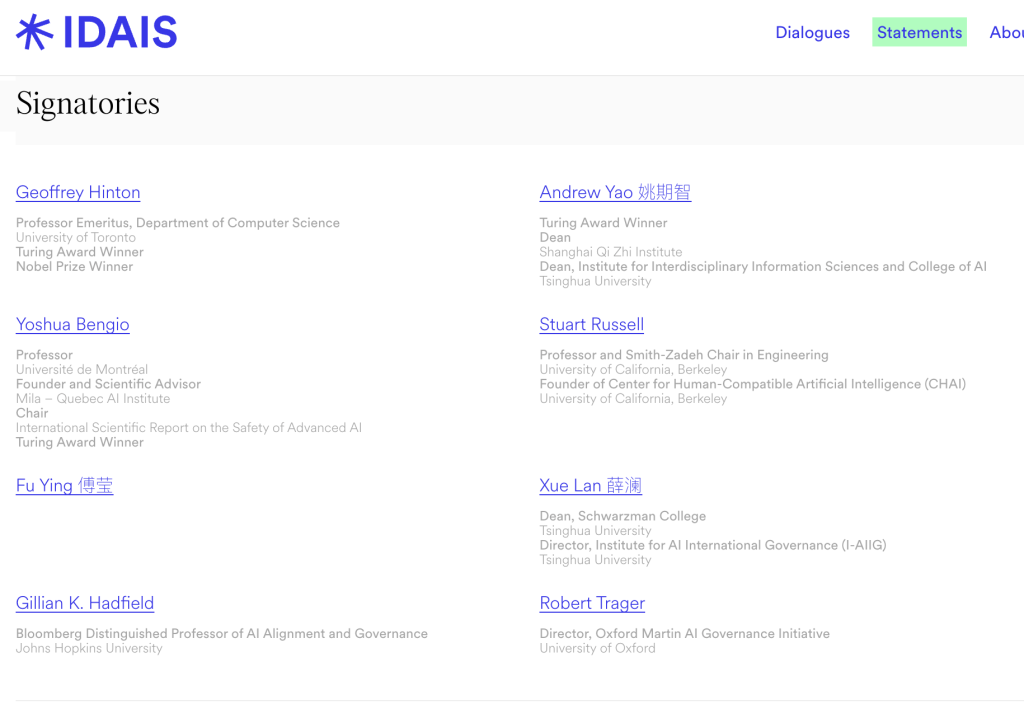

「国际社会应确立具体、可操作、受全球认可的红线,确保人工智能系统在任何情况下均不得逾越。」7 月 25 日, 由杰弗里·辛顿 (Geoffrey Hinton)、姚期智、本吉奥 (Yoshua Bengio)、斯图尔特·罗素 (Stuart Russell) 等 20 余位行业专家、学者共同签署的 AI 安全国际对话上海共识 (以下简称 「上海共识」) 正式对外公开。

参与签署的部分中外科学家来源:IDAIS 官网

此次对话是 「AI 安全国际对话」(International Dialogues on AI Safety - IDAIS) 系列的一部分 「。作为本次共识发起方之一,图灵奖得主、上海期智研究院的院长姚期智当日表示,」 我越来越相信,人类终将找到解决方案。

联名签署现场

2024 年 3 月,辛顿、姚期智、罗素、本吉奥等专家曾共同签署 「北京共识」,主张限制 AI 系统复制、欺骗、武器开发等行为,尤其呼吁行业为 AI 的研发和应用戴上 「紧箍咒」,避免相关技术被滥用,推动全球治理机构构建。姚期智透露,18 个月前举办第一次安全共识会议时,AGI 强大的破坏力就已经显现,人类甚至难以阐明其失控机制,不过随着相关会议的推进,已经看到若干有关基于 「设计的安全」(Safe by design) 提案,这意味着实际上人类可以找到确保 AI 安全的可行路径。

此次 「上海共识」 指出,当前人类正处于一个关键转折点:人工智能系统正迅速接近并可能超越人类智能水平。这些未来的系统可能在操作者毫不知情的情况下,执行并非操作者所期望或预测的行动。这可能导致失控,即一个或多个通用人工智能系统脱离任何人的控制,从而带来灾难性甚至是生存层面的风险。当前,对于能够在更高级的通用人工智能超越人类智能水平后,仍可靠地确保其对齐,并保持人类的有效控制尚无可行方法。

多位与会专家在参与讨论时也提及,当前构建真正有约束力且值得信赖的国际 AI 安全框架难度高、风险大。

上海人工智能实验室主任周伯文教授指出,目前 Make AI Safe(使得 AI 安全) 最大的问题在于它是事后价值对齐、修补的、被动回应的,通常是防御成本过高而攻击成本过低。而 Make Safe AI(构建安全的 AI) 是主动的、在线共同演进的,同时防御成本低,能够在各级风险上都保持应变能力。

周伯文认为,在一定程度上,训练一个模型变得友善和训练一个模型变得聪明可能是两条不同的技术路径。但当性能发展到某个程度,这两种能力可能很难分开处理——就像经典牛顿定律可以有效解释静止或慢速物体的运动,但是一旦逼近光速,这套理论就失效了。所以他认为,下一代模型的 「善」 与 「智」 未必能完全独立、分开发展,而是相互影响、共同进化的。

参与签署的专家之一,担任约翰·霍普金斯大学人工智能对齐与治理方向杰出教授吉莉恩·哈德菲尔 (Gillian Hadfield) 在接受包括澎湃科技在内的媒体采访时指出,必须通过设立 AI「红线」 来推动 Make AI Safe(使得 AI 安全),全世界需要跨国界合作。此外,要建立相应的 AI 安全合规系统。

为防范与纠正此类行为的技术路径与治理机制,「上海共识」 提出应对策略,并呼吁采取三项关键行动:要求前沿人工智能开发者提供安全保障、通过加强国际协调,共同确立并恪守可验证的全球性行为红线、投资基于设计的安全人工智能研究。

其中,对于开发者来说,「上海共识」 要求开发者在模型部署前应先进行全面的内部检查和第三方评估,提交高可信的安全案例,以及开展深入的模拟攻防与红队测试。若模型达到了关键能力阈值 (比如检测模型是否具备帮助没有专业知识的非法分子制造生化武器的能力),开发者应向政府 (在适当时亦可向公众) 说明潜在风险。

此外,呼吁国际社会需要合作划出人工智能开发不可以逾越的红线 (即 「高压线」),这些红线应聚焦于人工智能系统的行为表现,其划定需同时考量系统执行特定行为的能力及其采取该行为的倾向性。为落实这些红线,各国应建立一个具备技术能力、具有国际包容性的协调机构,汇聚各国人工智能安全主管机构,以共享风险相关信息,并推动评估规程与验证方法的标准化。

「上海共识」 指出,短期内亟须建立可扩展的监管机制以应对人工智能的欺骗问题、提升模型对 「越狱」 等攻击手段的抵御能力、强化信息安保投入等,而长期则需要一个 「基于设计的安全」 的架构,而非问题出现后才被动应对。

(澎湃新闻)

文章转载自东方财富