【文章来源:techweb】

【TechWeb】2 月 13 日消息,蚂蚁集团开源发布全球首个基于混合线性架构的万亿参数思考模型 Ring-2.5-1T,在长文本生成、数学推理与智能体任务执行上达到开源领先水平,为智能体 (Agent) 时代的复杂任务处理提供高性能基础支撑。

在生成效率上,Ring-2.5-1T 在 32K 以上长文本生成场景中,对比上代模型访存规模降低 10 倍以上,生成吞吐提升 3 倍以上。在深度思考能力方面,该模型在国际数学奥林匹克竞赛 (IMO 2025) 和中国数学奥林匹克 (CMO 2025) 自测均达到金牌水平 (IMO 35 分、CMO 105 分)。同时,可轻松适配 Claude Code 等智能体框架与 OpenClaw 个人 AI 助理,支持多步规划与工具调用。

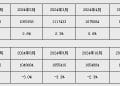

在多项权威基准测试中,Ring-2.5-1T 与 DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking、GPT-5.2-thinking-high、Gemini-3.0-Pro-preview-thinking-high、Claude-Opus-4.5-Extended-Thinking 等主流开源与闭源模型进行了系统对比,在数学推理、代码生成、逻辑推理和智能体任务执行等高难场景中达到开源领先水平。尤其在深度思考 (Heavy Thinking) 模式下,Ring-2.5-1T 在 IMOAnswerBench、HMMT-25 等数学竞赛推理基准和 LiveCodeBench-v6 代码生成基准中超越所有对比模型,展现了强大的复杂推理与跨任务泛化能力。

Ring-2.5-1T 基于 Ling 2.5 架构,通过优化注意力机制,显著提升长文本推理的效率与稳定性。模型激活参数规模从前代的 51B 提升至 63B,但在混合线性注意力架构的支持下,推理效率相比上一代大幅提升。与仅具备 32B 激活参数的 KIMI K2 架构相比,在 1T 总参数量下,Ling 2.5 架构在长序列推理任务中的吞吐表现依然优势显著,且随着生成长度增加,效率优势持续扩大。

随着 AI 大模型应用从短对话向长文档处理、跨文件代码理解、复杂任务规划等场景扩展,Ring-2.5-1T 有效缓解了长输出场景下计算开销高、推理速度慢的问题。该模型的开源也体现了蚂蚁百灵团队在大规模训练基础设施、算法优化和工程落地方面的综合能力,为行业提供了高性能、高效率的智能体时代基础模型新选择。

目前,Ring-2.5-1T 的模型权重与推理代码已在 Hugging Face、ModelScope 等主流开源平台发布。官方平台 Chat 体验页和 API 服务将在近期上线。

【文章来源:techweb】

【TechWeb】2 月 13 日消息,蚂蚁集团开源发布全球首个基于混合线性架构的万亿参数思考模型 Ring-2.5-1T,在长文本生成、数学推理与智能体任务执行上达到开源领先水平,为智能体 (Agent) 时代的复杂任务处理提供高性能基础支撑。

在生成效率上,Ring-2.5-1T 在 32K 以上长文本生成场景中,对比上代模型访存规模降低 10 倍以上,生成吞吐提升 3 倍以上。在深度思考能力方面,该模型在国际数学奥林匹克竞赛 (IMO 2025) 和中国数学奥林匹克 (CMO 2025) 自测均达到金牌水平 (IMO 35 分、CMO 105 分)。同时,可轻松适配 Claude Code 等智能体框架与 OpenClaw 个人 AI 助理,支持多步规划与工具调用。

在多项权威基准测试中,Ring-2.5-1T 与 DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking、GPT-5.2-thinking-high、Gemini-3.0-Pro-preview-thinking-high、Claude-Opus-4.5-Extended-Thinking 等主流开源与闭源模型进行了系统对比,在数学推理、代码生成、逻辑推理和智能体任务执行等高难场景中达到开源领先水平。尤其在深度思考 (Heavy Thinking) 模式下,Ring-2.5-1T 在 IMOAnswerBench、HMMT-25 等数学竞赛推理基准和 LiveCodeBench-v6 代码生成基准中超越所有对比模型,展现了强大的复杂推理与跨任务泛化能力。

Ring-2.5-1T 基于 Ling 2.5 架构,通过优化注意力机制,显著提升长文本推理的效率与稳定性。模型激活参数规模从前代的 51B 提升至 63B,但在混合线性注意力架构的支持下,推理效率相比上一代大幅提升。与仅具备 32B 激活参数的 KIMI K2 架构相比,在 1T 总参数量下,Ling 2.5 架构在长序列推理任务中的吞吐表现依然优势显著,且随着生成长度增加,效率优势持续扩大。

随着 AI 大模型应用从短对话向长文档处理、跨文件代码理解、复杂任务规划等场景扩展,Ring-2.5-1T 有效缓解了长输出场景下计算开销高、推理速度慢的问题。该模型的开源也体现了蚂蚁百灵团队在大规模训练基础设施、算法优化和工程落地方面的综合能力,为行业提供了高性能、高效率的智能体时代基础模型新选择。

目前,Ring-2.5-1T 的模型权重与推理代码已在 Hugging Face、ModelScope 等主流开源平台发布。官方平台 Chat 体验页和 API 服务将在近期上线。

【文章来源:techweb】

【TechWeb】2 月 13 日消息,蚂蚁集团开源发布全球首个基于混合线性架构的万亿参数思考模型 Ring-2.5-1T,在长文本生成、数学推理与智能体任务执行上达到开源领先水平,为智能体 (Agent) 时代的复杂任务处理提供高性能基础支撑。

在生成效率上,Ring-2.5-1T 在 32K 以上长文本生成场景中,对比上代模型访存规模降低 10 倍以上,生成吞吐提升 3 倍以上。在深度思考能力方面,该模型在国际数学奥林匹克竞赛 (IMO 2025) 和中国数学奥林匹克 (CMO 2025) 自测均达到金牌水平 (IMO 35 分、CMO 105 分)。同时,可轻松适配 Claude Code 等智能体框架与 OpenClaw 个人 AI 助理,支持多步规划与工具调用。

在多项权威基准测试中,Ring-2.5-1T 与 DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking、GPT-5.2-thinking-high、Gemini-3.0-Pro-preview-thinking-high、Claude-Opus-4.5-Extended-Thinking 等主流开源与闭源模型进行了系统对比,在数学推理、代码生成、逻辑推理和智能体任务执行等高难场景中达到开源领先水平。尤其在深度思考 (Heavy Thinking) 模式下,Ring-2.5-1T 在 IMOAnswerBench、HMMT-25 等数学竞赛推理基准和 LiveCodeBench-v6 代码生成基准中超越所有对比模型,展现了强大的复杂推理与跨任务泛化能力。

Ring-2.5-1T 基于 Ling 2.5 架构,通过优化注意力机制,显著提升长文本推理的效率与稳定性。模型激活参数规模从前代的 51B 提升至 63B,但在混合线性注意力架构的支持下,推理效率相比上一代大幅提升。与仅具备 32B 激活参数的 KIMI K2 架构相比,在 1T 总参数量下,Ling 2.5 架构在长序列推理任务中的吞吐表现依然优势显著,且随着生成长度增加,效率优势持续扩大。

随着 AI 大模型应用从短对话向长文档处理、跨文件代码理解、复杂任务规划等场景扩展,Ring-2.5-1T 有效缓解了长输出场景下计算开销高、推理速度慢的问题。该模型的开源也体现了蚂蚁百灵团队在大规模训练基础设施、算法优化和工程落地方面的综合能力,为行业提供了高性能、高效率的智能体时代基础模型新选择。

目前,Ring-2.5-1T 的模型权重与推理代码已在 Hugging Face、ModelScope 等主流开源平台发布。官方平台 Chat 体验页和 API 服务将在近期上线。

【文章来源:techweb】

【TechWeb】2 月 13 日消息,蚂蚁集团开源发布全球首个基于混合线性架构的万亿参数思考模型 Ring-2.5-1T,在长文本生成、数学推理与智能体任务执行上达到开源领先水平,为智能体 (Agent) 时代的复杂任务处理提供高性能基础支撑。

在生成效率上,Ring-2.5-1T 在 32K 以上长文本生成场景中,对比上代模型访存规模降低 10 倍以上,生成吞吐提升 3 倍以上。在深度思考能力方面,该模型在国际数学奥林匹克竞赛 (IMO 2025) 和中国数学奥林匹克 (CMO 2025) 自测均达到金牌水平 (IMO 35 分、CMO 105 分)。同时,可轻松适配 Claude Code 等智能体框架与 OpenClaw 个人 AI 助理,支持多步规划与工具调用。

在多项权威基准测试中,Ring-2.5-1T 与 DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking、GPT-5.2-thinking-high、Gemini-3.0-Pro-preview-thinking-high、Claude-Opus-4.5-Extended-Thinking 等主流开源与闭源模型进行了系统对比,在数学推理、代码生成、逻辑推理和智能体任务执行等高难场景中达到开源领先水平。尤其在深度思考 (Heavy Thinking) 模式下,Ring-2.5-1T 在 IMOAnswerBench、HMMT-25 等数学竞赛推理基准和 LiveCodeBench-v6 代码生成基准中超越所有对比模型,展现了强大的复杂推理与跨任务泛化能力。

Ring-2.5-1T 基于 Ling 2.5 架构,通过优化注意力机制,显著提升长文本推理的效率与稳定性。模型激活参数规模从前代的 51B 提升至 63B,但在混合线性注意力架构的支持下,推理效率相比上一代大幅提升。与仅具备 32B 激活参数的 KIMI K2 架构相比,在 1T 总参数量下,Ling 2.5 架构在长序列推理任务中的吞吐表现依然优势显著,且随着生成长度增加,效率优势持续扩大。

随着 AI 大模型应用从短对话向长文档处理、跨文件代码理解、复杂任务规划等场景扩展,Ring-2.5-1T 有效缓解了长输出场景下计算开销高、推理速度慢的问题。该模型的开源也体现了蚂蚁百灵团队在大规模训练基础设施、算法优化和工程落地方面的综合能力,为行业提供了高性能、高效率的智能体时代基础模型新选择。

目前,Ring-2.5-1T 的模型权重与推理代码已在 Hugging Face、ModelScope 等主流开源平台发布。官方平台 Chat 体验页和 API 服务将在近期上线。