作者:

李玉洋

三个月之内,「AI 教父」 黄仁勋两次踏上中国土地,这次他脱下经典皮衣、换上西装,出现在公众视野。

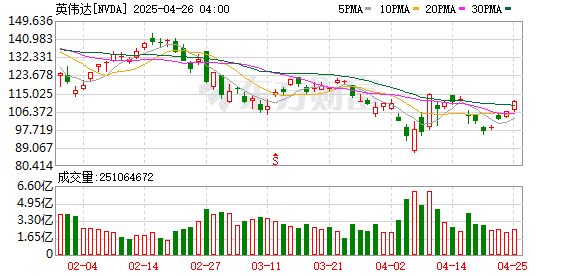

近日,英伟达(NASDAQ:NVDA) 总裁兼 CEO 黄仁勋来到中国开展为期两天的访问。此前一天,英伟达披露美国政府告知该公司的 H20 芯片出口到中国需要许可证,且将无限期实施。此外,美国商务部还对 AMD MI308(一款中国特供产品) 以及同类型的 AI 芯片,均新增了中国出口许可要求。

随着今年年初 DeepSeek 的爆红,国内推理算力需求出现井喷式增长,外媒报道称腾讯、百度等大厂都加大了 H20 的采购订单,即使 H20 性能被严重 「阉割」。由于美国政府限制 H20 向中国出口,英伟达表示,预计 2026 财年第一季度 (对应自然日期截至 4 月 27 日) 业绩将不得不承担 55 亿美元 (约合人民币 400 亿元) 的费用,这些费用与 H20 产品的库存、采购订单和相关储备有关。

过去半个多月,在美国加征关税这个大背景下,全球半导体产业链备受冲击。「行情变化太快。」 英伟达国内代理商思腾合力的一名销售人员告诉 《中国经营报》 记者,一款搭载 8 张 H20(内存 141G) 的推理服务器现货目前售价约 140 万元,而今年年初价格在 100 万元左右,「价格可能后面还会涨」。

对于美国全面封杀英伟达 H20 及同类型的 AI 芯片对华出口,有分析指出,国内 AI 芯片厂商有了前所未有的市场空间去验证自身产品的性能、可靠性、生态兼容性以及供应链的稳定性等。「这对国内是利好的,因为企业对 AI 的诉求有增无减,而且中国智算中心市场还在增长,对国产化的要求还挺高。」 行业研究机构 Omdia 人工智能首席分析师苏廉节对记者表示。

数据中心收入将下降 8% 至 9%

需要说明的是,在 2023 年 10 月,美国新一轮对华出口 AI 芯片限制生效后,H20 是英伟达向中国客户能合法销售的特供版 AI 芯片。

据了解,H20 是基于英伟达 Hopper 架构,有两种内存的版本 (96GB 的 HBM3 和 141GB 的 HBM3e),与 H100 相比,其性能大幅缩水约 80%,且禁用张量核心,限制了超频和集群扩展。有消息称,H20 96GB 版本已经停产,141GB 版本更适合超大规模推理集群部署。

而 141GB 版本的 H20 的 FP16 精度算力还不到 H200 的 1/10,但显存极大,由此该版本因 「算力与显存配置畸形」 而引发讨论,加上国内 AI 芯片的激烈竞争,H20 的市场竞争力大打折扣,质疑声不绝于耳。

然而,DeepSeek 的火爆,让 H20 141GB 版本凭借显存和带宽的强化 (8 卡总显存达 1128GB),原生支持 FP8 精度的 DeepSeek-R1 671B 满血版模型,可流畅运行千亿参数规模的模型推理任务,成为当前中国市场适配大模型推理的热门选择。

DeepSeek 证明了 H20 的 「香」。据传,此前腾讯、字节跳动、阿里巴巴等多家中国巨头花费 160 亿美元采购 H20。因此,主要为推理设计的 H20,成为今年第一季度国内卖得最好的 AI 芯片。在此期间,市场上一直流传 「H20 即将被禁」 的说法,现在靴子终于落地了。

值得一提的是,面向中国市场的 H20 141GB 版本并没有 DGX 系统,DGX 系统 (如 DGX H100/H200) 是英伟达直接提供的 AI 服务器,包含完整的硬件 (GPU、CPU、网络等) 和预装软件生态 (如 NVIDIA AI Enterprise),定位为 「即插即用」 的 AI 基础设施。

根据公开信息,英伟达 H20 主要作为合规特供的 GPU 模组 (HGX 形态) 提供给中国市场,供 OEM 厂商集成到自有服务器产品中。

上述英伟达国内代理商表示,他们的 H20 现货产品都是固定配置 (2×8558/16×64G/2×960G/4×3.84/8×H20 141G),其中 8558 指的是最新一代 Intel 8558P 处理器,尽管还不知道 H20 现货何时不能在国内销售,但其表示,「不用担心保修」。

此次 H20 芯片对华出口管制,意味着英伟达已量产的最近三代架构的数据中心级 AI 芯片 (GPU) 已无缘中国市场,不管是最新 Blackwell 架构的 B100/200,还是高端版 H100/200、A100 等,或是特供版 H800、A800 以及 H20。

黄仁勋也承认,美国政府加强芯片出口管制已对英伟达的业务产生重大影响,而中国是英伟达非常重要的市场,将继续不遗余力优化符合监管要求的产品体系,坚定不移地服务中国市场。

有消息称,英伟达专供我国的 H20 单款产品在 2024 年贡献了该公司中国区 170 亿美元年营收的 70%。而摩根士丹利分析师下调了英伟达的营收预期,理由是担心美国对中国的最新芯片出口限制对英伟达的影响,他们预计未来几个季度,英伟达的数据中心收入将下降 8% 至 9%。

构建国产算力版图

如何评估 DeepSeek 对算力生态的影响?业界有两个共识:一是 DeepSeek 把蛋糕做大了;二是模型训练需求将远小于推理需求。目前,英伟达的 AI 芯片在训练方面表现最佳,但推理芯片的最佳选择尚不确定。

IDC 认为,通过适配 DeepSeek,中国本土 AI 芯片在软件生态领域实现了突破,逐步完善软件生态。这为本土 AI 芯片在市场中的竞争力提供了有力支持,同时也促进了本土厂商的技术交流和资源共享,打破了国产芯片生态建设的僵局。

而美国政府对华出口 AI 芯片的进一步管制,将倒逼中国企业更多使用国产 AI 芯片,国内 AI 芯片行业直面替代大考的机会真的来了。

有观点认为,目前国内 AI 芯片和国际先进水平大概差 1.5 代,国内大多数 AI 芯片性能已接近英伟达 A 系列,最新一代接近 H 系列。

谁最可能替代英伟达 GPU,华为的昇腾 (Ascend) 系列芯片无疑是当前最受瞩目,且在实际部署上走得最远的本土选项,尤其是以昇腾 910C 为代表的最新一代产品,正成为中国构建本土 AI 基础设施的核心。

根据 Huawei Central、TrendForce News 和 Reddit 等平台的研究分析,昇腾 910C 是通过共封装或芯粒技术将两个昇腾 910B 芯片组合而成,由此计算能力显著提升,达到了 800 TFLOP/s(FP16 精度) 的计算能力和 3.2 TB/s 的内存带宽,性能可达到英伟达 H100 的 80%。

其超节点在规模及推理性能已比肩英伟达 NVL72 超节点的水平。而这和构成该计算系统最核心的华为昇腾910C 芯片密不可分。

「最近有些消息说,华为下一代昇腾 920 会出来。」 苏廉节表示,基于制裁,昇腾 920 性能还是无法跟最顶尖的 GPU 相提并论,但估计也会爆单。

此外,华为还将芯片的能力延伸至系统层面,通过 CloudMatrix 这样的计算系统来聚合算力。近日,华为云推出 CloudMatrix 384 超节点,并宣布已在芜湖数据中心规模上线。

尽管目前,华为昇腾 910C 在国内应用和替代中处在领跑的位置,但事实上在国内 AI 芯片领域,互联网大厂阿里巴巴、百度、腾讯均已布局自研 AI 芯片;在纯芯片厂商中,既有寒武纪、海光信息等上市公司,也涌现出如摩尔线程、壁仞科技、瀚博半导体、沐曦、燧原科技、天数智芯、地平线等一批兼具技术沉淀与创新活力的企业。

可以说,美国商务部的禁令清单每延长一寸,中国本土 AI 芯片厂商的订单便增厚一尺——寒武纪的云端训练卡、地平线的自动驾驶芯片、华为的昇腾生态,正以美方禁令倒逼下的超线性速度,填补着算力版图的裂缝。

除以上芯片企业在构建国产算力外,记者注意到一些处于中间层的 AI Infra(基础设施) 公司也在助力用好国产算力。

清华系的清程极智就是这样一家企业。清程极智 CEO 汤雄超此前接受媒体采访时表示,DeepSeek 模型采用的 FP8 数据格式与英伟达 H 系列卡深度绑定,但目前大多数国产芯片尚没法原生支持 FP8。

「从这个层面看,硬件层面产品的代际差距拉大了。」 汤雄超认为,发挥 Infra 层的作用,通过软硬协同,将优秀的国产大模型和国产硬件更好协同起来,以及把市场上的闲置算力更好地用起来,这是公司始终在思考的。

今年年初,清程极智与清华共同开源了大模型推理引擎 「赤兔」,通过赤兔的部署,大部分英伟达老、旧卡及国产芯片都可支撑 DeepSeek 满血版,与此同时在首期开源的版本中,对比国际主流开源推理引擎,在算力减少一半的基础上,速度还能翻番。

短期来看,赤兔实现了 DeepSeek FP8 精度模型在存量 GPU 上的无损且高效部署;长期来看,赤兔这些模型推理引擎的开源将是形成国产大模型、国产算力和国产引擎闭环的必要环节。

(中国经营网)

文章转载自东方财富