来源:

财联社

人工智能正以史无前例的速度重塑各行业,这场变革背后离不开海量算力的支持。当 AI 模型参数从亿级跃升至万亿级,「超节点」 开始逐渐取代单机与传统集群,成为新一代的 「算力法宝」。

超节点,即 Superpod,是一种用于构建大规模算力集群的技术架构。此概念最早由英伟达提出,指将数千张 GPU 集成在一个逻辑单元内,形成类似 「超级计算节点」 的系统。与传统架构不同的是,超节点可以通过高速互联技术,弥补原先服务器间带宽不足以及高时延等问题,以期实现算力效率的优化。

在不久前举行的 2025 云栖大会上,阿里云发布了磐久 128 超节点 AI 服务器。据悉,该服务器集成阿里自研 CIPU 2.0 芯片和 EIC/MOC 高性能网卡,单柜支持 128 个 AI 计算芯片。同等算力下,相较于传统架构,该服务器推理性能可提升 50%。

除推理场景外,超节点亦可用于 AI 训练。今年 4 月,华为推出 CloudMatrix 384 超节点,其通过构建超过万片的大集群来提供算力。对于万亿、十万亿参数的大模型训练任务,在云数据中心,可将 432 个超节点级联成最高 16 万卡的超大集群。

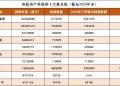

在 9 月召开的华为全连接大会上,华为表示 CloudMatrix 384 超节点已销售 300 余套,共服务 20 余家客户,主要需求来自政企。未来,华为还将推出 Atlas 950 SuperPoD 超节点,算力规模 8192 卡,预计于 2026 年四季度上市。新一代产品 Atlas 960 SuperPoD 算力规模将达到 15488 卡,预计 2027 年四季度上市。

华龙证券指出,中美 AI 竞争正从 「单卡性能」 走向 「系统级效率」,中国正在用集群建设+开源生态+工程化交付的方式完成 AI 基建方面的弯道超车。事实上,当前还有更多国产硬件厂商正在加速布局超节点:

8 月 7 日,浪潮信息发布面向万亿参数大模型的超节点 AI 服务器 「元脑 SD200」。

沐曦股份已发布多种超节点形态,包括光互连超节点、耀龙 3D Mesh 超节点、Shanghai Cube 国产高密度液冷整机柜以及高密度液冷算力 POD。

8 月 28 日,百度智能云发布百舸 AI 计算平台 5.0 版本。在算力方面,昆仑芯超节点正式启用。

从技术方向看,超节点正在成为 AI 基础设施建设的新常态。民生证券认为,此前市场更多关注芯片算力,但伴随 Scale up 产业趋势崛起,超节点已经重新定义 AI 基础设施的范式。

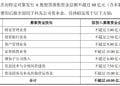

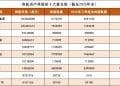

以华为超节点为例,其柜间采用全光互联,具有高可靠、高带宽、低时延等优势;另一方面,华为的 Atlas 950 通过正交架构,实现零线缆电互联,其独创的材料和工艺让光模块液冷可靠性提升 1 倍。相比英伟达将在明年下半年上市的 NVL144,Atlas950 超节点卡的规模是其 56.8 倍,总算力是其 6.7 倍,内存容量是其 15 倍,互联带宽是其 62 倍,在各方面均呈领先。

该机构进一步指出,当超节点速率大幅提升,AIDC 功率将迎来新挑战。由于包括华为 CloudMatrix 384、英伟达 GB200NVL72 在内的超节点单机柜功耗普遍突破 100KW,因此在算力密度指数级增加的情况下,超节点机柜的温控和电源系统将面临挑战。而当 Atlas950 超节点采用全液冷模式时,其互联带宽速率和算力速率均有望迎来大幅提升。

从投资层面来看,国金证券表示,华为超节点等新平台在算力、带宽、内存等关键指标上全面领先,有望推动国产算力基础设施加速落地。看好超节点渗透率的持续提升,带动光连接供应链的放量。

(财联社)

文章转载自东方财富