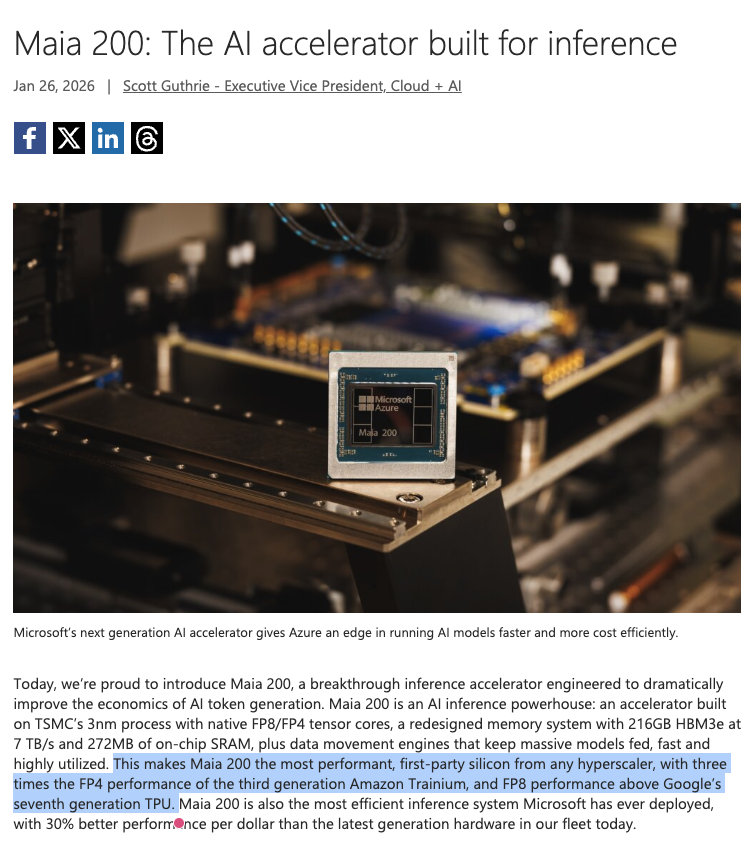

继去年底谷歌、亚马逊先后发布自研算力芯片后,同为全球云计算「三巨头」 的微软终于在本周 「交卷」——传闻已久的 Maia 200 芯片正式面世。

微软在公告中表示,这款 「为推理而生」 的芯片在多项测试中超越亚马逊的第三代 Trainium 和谷歌第七代 TPU。因此,微软将 Maia 200 公开称为 「所有超大规模云服务商中性能最强的自研芯片」。

(来源:公司官网)

据公司介绍,Maia 200 采用台积电3nm 工艺制造,内建原生 FP8/FP4 张量核。每颗芯片包含超过 1400 亿个晶体管,专为大规模 AI 工作负载量身打造,特别是采用低精度计算的最新一代 AI 大模型。

微软披露,单颗 Maia 200 芯片在 4 位精度 (FP4) 可提供超过 10 PetaFLOPS 的算力,在 8 位精度 (FP8) 下也能超过 5 PetaFLOPS,而且整个 SoC 的热设计功耗能够控制在 750W 以内。科技巨头强调,在实际运行中,单块 Maia 200 就能轻松运行当今最大的 AI 模型,同时还为未来更大型的模型留有余量。

除了芯片本身的算力外,微软也在存储参数上猛 「堆料」。公司披露,Maia 200 配备 216GB、带宽达 7TB/s 的 HBM3e,以及 272MB 的片上 SRAM。在拓展层面,每块芯片提供 2.8TB/s 的双向专用扩展带宽,支持在 6144 个加速器集群中提供可预测的高性能集合操作。

因此,微软芯片在 「跑分」 上赢过另外两家竞品也在情理之中。微软在公告中表示,Maia 200 的 FP4 性能是亚马逊第三代 Trainium 的 3 倍有余,且在 FP8 性能上超越谷歌第七代 TPU。

除了性能外,作为云服务商的自研芯片,省钱也是一项关键指标。微软透露,Maia 200 是公司迄今部署过的效率最高推理系统,其 「每美元性能」 相比当前机群中最新一代硬件提升了 30%。

作为云服务商竞相推出自研芯片的背景,随着 AI 服务日渐成熟,推理成本已经成为整体运营中日益重要的部分,促使云服务供应商关注如何单独为这块需求提供更具性价比的方案,特别是要比英伟达GPU 更具性价比。本质上,微软、谷歌和亚马逊发布的自研芯片,都是在承担原本需要英伟达 GPU 处理的计算任务,从而降低整体成本。

非常有趣的是,微软似乎不止 「优化」 了英伟达的芯片。公司披露,每台 Maia 200 服务器中包含 4 块芯片,依靠以太网连接,而不是 InfiniBand 标准。而 InfiniBand 交换机正是英伟达在 2020 年收购 Mellanox 后所销售的产品。

微软透露,目前正在为美国中部地区的数据中心配备最新款芯片,之后会在更多地点部署。目前尚不清楚 Azure 云服务的用户何时能使用搭载该芯片的服务器。

微软此前也表示,已经在设计该芯片的后续产品 Maia 300。科技巨头也与 OpenAI 达成协议,可以使用初创公司的芯片设计。

(财联社)

文章转载自 东方财富