【文章来源:techweb】

【TechWeb】10 月 9 日消息,今天凌晨,蚂蚁集团发布万亿参数的通用语言模型 Ling-1T。Ling-1T 是蚂蚁百灵大模型 Ling 2.0 系列的第一款旗舰模型,也是蚂蚁百灵团队迄今为止推出的规模最大、能力最强的非思考大模型。

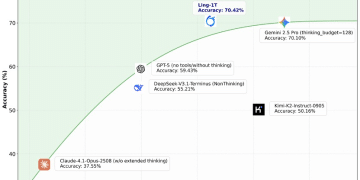

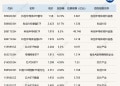

测评显示,在有限输出 Token 条件下,Ling-1T 于多项复杂推理基准中取得 SOTA 表现。另外,在代码生成、软件开发、竞赛数学、专业数学、逻辑推理等多项高难度基准测试上,Ling-1T 均取得领先成绩,多项指标位居开源模型的榜首。

以竞赛数学榜单 AIME 25 (American Invitation Math Examination 25) 为例,Ling-1T 以平均 4000+ Token 的消耗达到了 70.42% 的准确率,优于 Gemini-2.5-Pro(平均 5000+ Token,准确率 70.10%)。Ling-1T 用更少的 Token 实现了更高的准确率,展现出在推理精度和思考效率综合能力上的优势。

据蚂蚁百灵团队透露,Ling-1T 沿用 Ling 2.0 架构,在 20T+ tokens 高质量、高推理浓度的语料上完成预训练,支持最高 128K 上下文窗口,通过 「中训练+后训练」 的演进式思维链 (Evo-CoT) 提升模型高效思考和精准推理能力。

值得一提的是,Ling-1T 全程采用 FP8 混合精度训练 (部分技术已开源),是目前已知规模最大的使用 FP8 训练的基座模型。这一设计为训练带来了显著的显存节省、更灵活的并行切分策略和 15%+ 的端到端加速。

在强化学习阶段,蚂蚁百灵团队创提出了 LPO 方法 (Linguistics-Unit Policy Optimization,LingPO) ,这是一种以 「句子」 为粒度的策略优化算法,为万亿参数模型的稳定训练提供了关键支持。这种方法既避免了词元级别的破碎感,也克服了序列级别的笼统性,使得奖励信号与模型行为在语义层面实现了更精准的对齐。

另外,蚂蚁百灵团队提出了 「语法-功能-美学」 的混合奖励机制,在确保代码正确、功能完善的同时持续提升这个万亿基座对视觉美学的认知。在 ArtifactsBench 前端能力基准上,Ling-1T 得分 59.31,在可视化和前端开发任务领域,仅次于 Gemini-2.5-Pro-lowthink 的得分 60.28。

据了解,除了 Ling-1T 这款非思考模型,蚂蚁百灵团队还在训练万亿参数级的深度思考大模型 Ring-1T,已在 9 月 30 日开源了 preview 版。目前,开发者通过 Hugging Face 和蚂蚁百宝箱等平台都可以体验 Ling-1T 模型。

【文章来源:techweb】

【TechWeb】10 月 9 日消息,今天凌晨,蚂蚁集团发布万亿参数的通用语言模型 Ling-1T。Ling-1T 是蚂蚁百灵大模型 Ling 2.0 系列的第一款旗舰模型,也是蚂蚁百灵团队迄今为止推出的规模最大、能力最强的非思考大模型。

测评显示,在有限输出 Token 条件下,Ling-1T 于多项复杂推理基准中取得 SOTA 表现。另外,在代码生成、软件开发、竞赛数学、专业数学、逻辑推理等多项高难度基准测试上,Ling-1T 均取得领先成绩,多项指标位居开源模型的榜首。

以竞赛数学榜单 AIME 25 (American Invitation Math Examination 25) 为例,Ling-1T 以平均 4000+ Token 的消耗达到了 70.42% 的准确率,优于 Gemini-2.5-Pro(平均 5000+ Token,准确率 70.10%)。Ling-1T 用更少的 Token 实现了更高的准确率,展现出在推理精度和思考效率综合能力上的优势。

据蚂蚁百灵团队透露,Ling-1T 沿用 Ling 2.0 架构,在 20T+ tokens 高质量、高推理浓度的语料上完成预训练,支持最高 128K 上下文窗口,通过 「中训练+后训练」 的演进式思维链 (Evo-CoT) 提升模型高效思考和精准推理能力。

值得一提的是,Ling-1T 全程采用 FP8 混合精度训练 (部分技术已开源),是目前已知规模最大的使用 FP8 训练的基座模型。这一设计为训练带来了显著的显存节省、更灵活的并行切分策略和 15%+ 的端到端加速。

在强化学习阶段,蚂蚁百灵团队创提出了 LPO 方法 (Linguistics-Unit Policy Optimization,LingPO) ,这是一种以 「句子」 为粒度的策略优化算法,为万亿参数模型的稳定训练提供了关键支持。这种方法既避免了词元级别的破碎感,也克服了序列级别的笼统性,使得奖励信号与模型行为在语义层面实现了更精准的对齐。

另外,蚂蚁百灵团队提出了 「语法-功能-美学」 的混合奖励机制,在确保代码正确、功能完善的同时持续提升这个万亿基座对视觉美学的认知。在 ArtifactsBench 前端能力基准上,Ling-1T 得分 59.31,在可视化和前端开发任务领域,仅次于 Gemini-2.5-Pro-lowthink 的得分 60.28。

据了解,除了 Ling-1T 这款非思考模型,蚂蚁百灵团队还在训练万亿参数级的深度思考大模型 Ring-1T,已在 9 月 30 日开源了 preview 版。目前,开发者通过 Hugging Face 和蚂蚁百宝箱等平台都可以体验 Ling-1T 模型。

【文章来源:techweb】

【TechWeb】10 月 9 日消息,今天凌晨,蚂蚁集团发布万亿参数的通用语言模型 Ling-1T。Ling-1T 是蚂蚁百灵大模型 Ling 2.0 系列的第一款旗舰模型,也是蚂蚁百灵团队迄今为止推出的规模最大、能力最强的非思考大模型。

测评显示,在有限输出 Token 条件下,Ling-1T 于多项复杂推理基准中取得 SOTA 表现。另外,在代码生成、软件开发、竞赛数学、专业数学、逻辑推理等多项高难度基准测试上,Ling-1T 均取得领先成绩,多项指标位居开源模型的榜首。

以竞赛数学榜单 AIME 25 (American Invitation Math Examination 25) 为例,Ling-1T 以平均 4000+ Token 的消耗达到了 70.42% 的准确率,优于 Gemini-2.5-Pro(平均 5000+ Token,准确率 70.10%)。Ling-1T 用更少的 Token 实现了更高的准确率,展现出在推理精度和思考效率综合能力上的优势。

据蚂蚁百灵团队透露,Ling-1T 沿用 Ling 2.0 架构,在 20T+ tokens 高质量、高推理浓度的语料上完成预训练,支持最高 128K 上下文窗口,通过 「中训练+后训练」 的演进式思维链 (Evo-CoT) 提升模型高效思考和精准推理能力。

值得一提的是,Ling-1T 全程采用 FP8 混合精度训练 (部分技术已开源),是目前已知规模最大的使用 FP8 训练的基座模型。这一设计为训练带来了显著的显存节省、更灵活的并行切分策略和 15%+ 的端到端加速。

在强化学习阶段,蚂蚁百灵团队创提出了 LPO 方法 (Linguistics-Unit Policy Optimization,LingPO) ,这是一种以 「句子」 为粒度的策略优化算法,为万亿参数模型的稳定训练提供了关键支持。这种方法既避免了词元级别的破碎感,也克服了序列级别的笼统性,使得奖励信号与模型行为在语义层面实现了更精准的对齐。

另外,蚂蚁百灵团队提出了 「语法-功能-美学」 的混合奖励机制,在确保代码正确、功能完善的同时持续提升这个万亿基座对视觉美学的认知。在 ArtifactsBench 前端能力基准上,Ling-1T 得分 59.31,在可视化和前端开发任务领域,仅次于 Gemini-2.5-Pro-lowthink 的得分 60.28。

据了解,除了 Ling-1T 这款非思考模型,蚂蚁百灵团队还在训练万亿参数级的深度思考大模型 Ring-1T,已在 9 月 30 日开源了 preview 版。目前,开发者通过 Hugging Face 和蚂蚁百宝箱等平台都可以体验 Ling-1T 模型。

【文章来源:techweb】

【TechWeb】10 月 9 日消息,今天凌晨,蚂蚁集团发布万亿参数的通用语言模型 Ling-1T。Ling-1T 是蚂蚁百灵大模型 Ling 2.0 系列的第一款旗舰模型,也是蚂蚁百灵团队迄今为止推出的规模最大、能力最强的非思考大模型。

测评显示,在有限输出 Token 条件下,Ling-1T 于多项复杂推理基准中取得 SOTA 表现。另外,在代码生成、软件开发、竞赛数学、专业数学、逻辑推理等多项高难度基准测试上,Ling-1T 均取得领先成绩,多项指标位居开源模型的榜首。

以竞赛数学榜单 AIME 25 (American Invitation Math Examination 25) 为例,Ling-1T 以平均 4000+ Token 的消耗达到了 70.42% 的准确率,优于 Gemini-2.5-Pro(平均 5000+ Token,准确率 70.10%)。Ling-1T 用更少的 Token 实现了更高的准确率,展现出在推理精度和思考效率综合能力上的优势。

据蚂蚁百灵团队透露,Ling-1T 沿用 Ling 2.0 架构,在 20T+ tokens 高质量、高推理浓度的语料上完成预训练,支持最高 128K 上下文窗口,通过 「中训练+后训练」 的演进式思维链 (Evo-CoT) 提升模型高效思考和精准推理能力。

值得一提的是,Ling-1T 全程采用 FP8 混合精度训练 (部分技术已开源),是目前已知规模最大的使用 FP8 训练的基座模型。这一设计为训练带来了显著的显存节省、更灵活的并行切分策略和 15%+ 的端到端加速。

在强化学习阶段,蚂蚁百灵团队创提出了 LPO 方法 (Linguistics-Unit Policy Optimization,LingPO) ,这是一种以 「句子」 为粒度的策略优化算法,为万亿参数模型的稳定训练提供了关键支持。这种方法既避免了词元级别的破碎感,也克服了序列级别的笼统性,使得奖励信号与模型行为在语义层面实现了更精准的对齐。

另外,蚂蚁百灵团队提出了 「语法-功能-美学」 的混合奖励机制,在确保代码正确、功能完善的同时持续提升这个万亿基座对视觉美学的认知。在 ArtifactsBench 前端能力基准上,Ling-1T 得分 59.31,在可视化和前端开发任务领域,仅次于 Gemini-2.5-Pro-lowthink 的得分 60.28。

据了解,除了 Ling-1T 这款非思考模型,蚂蚁百灵团队还在训练万亿参数级的深度思考大模型 Ring-1T,已在 9 月 30 日开源了 preview 版。目前,开发者通过 Hugging Face 和蚂蚁百宝箱等平台都可以体验 Ling-1T 模型。